|

前言 [PConline 专业评测]今年8月,AMD发布了第二代EPYC处理器,代号Rome。无论是x86业界最高的64个物理核心,还是前卫的9 die设计,亦或是7nm的先进工艺都引起了市场和行业的广泛兴趣。 AMD所面对的市场时一个长期被Intel统治的市场,是一个大家只能跟着Intel的步伐亦步亦趋的市场。在这样一个市场中,大家最希望见到的是一个有足够分量的挑战者,重新摆正已经偏斜的市场天平,激发市场上游的活力。 而这也正是Rome一经宣布便掀起如此大波澜的原因。 当然,从AMD的角度来说,能够在产品发布之初就获得市场的普遍关注当然是好事。但如果想要将这种关注化为实实在在的市场占有率和收入,产品的实力同样不可或缺。 但坦率的说,在服务器市场,AMD是摔过跤的。彼时的AMD,不仅在与Intel的竞争中无法守住原有的市场份额,甚至还有几年时间完全没有针对这一市场的新品推出。此次,凭借EPYC品牌重回数据中心市场,AMD所需的诚意和本钱无疑会更高。 故事从那不勒斯开始 我们今日熟识的那不勒斯是意大利东南的一座繁华滨海城市。但将时钟回拨2700年,当年的那不勒斯却是罗马共和国抵御迦太基进攻的前线,凭借坚固的城墙,要塞化的那不勒斯挡住了当年如日中天的汉尼拔,使其扎根南部意大利蚕食罗马共和国的计划最终泡汤。 而AMD的那不勒斯也正如同当年的那不勒斯一般,坚固、强大,但并非锋芒毕露。 2017年,AMD发布第一代EPYC平台,核心代号Naples(那不勒斯)。一如当年抵御汉尼拔大军的那不勒斯城一般,第一代EPYC作为AMD重返数据中心市场的桥头堡,为市场带来了一些非常有吸引力的特性——多晶片Chiplets封装、更多的内存通道以及第一代Infinity Fabric总线。这些特性也一如那不勒斯当年坚固的城墙那般,在汹涌的蓝色洪流当中为AMD成功的扎下了坚实的根基。 8通道DDR4内存总线为Naples带来了更大的内存带宽,Chiplets封装为Naples带来了高性价比的32核心,而Infinity Fabric总线则为封装之内的晶片互联提供了很低的时延表现。最终,Naples从单路服务器应用市场开始,成功为AMD打开了重回服务器市场的大门。 从上图中我们不难看出,在双Socket情况下,每个晶片所对应的NUMA域将分为三种通讯距离,即域内(NUMA1内部)、域外Socket内(NUMA2)和域外Socket外(NUMA3)。三种互联情况的延迟成倍递增,互联带宽成倍递减(至于为什么会把NUMA1与NUMA3中有直连总线的情况也与需要跳转通讯的情况归为一类,我们会在下面进行解释)。 由于Naples当中的每个晶片(die)上包含了4个Infinity Fabric结构。这种结构虽然能够在Socket内互联时取得不错的效果,但一旦需要跨Socket通讯,情况就会变得相当复杂。 这样相对复杂的组合所带来的最直接结果便是双路应用中处理器互联效率的损失。换句话说,在大规模虚拟化应用中(尤其是超售情况下),主流的双路Naples系统效能将会相对较低。 而这也就解释了为何Naples架构虽然有众多亮点,但却在单路应用中获得了更好的反响。 当然,作为AMD在数据中心市场久别重逢的新作,Naples仍旧足够优秀、足够引人注意,让AMD得以重回服务器市场。而Naples本身的不足也为之后到来的Rome订好了方向。 大刀阔斧,构建理想的Rome Rome,即是横跨千年的罗马共和国(帝国),亦是当时世界上最恢宏的都城,汇集了所有人对于璀璨城市的所有美好想象。斗兽场、元老院议事堂、凯旋门、罗马广场……都是这座辉煌都城的名片。 而在找到前进方向之后,AMD也同样在Rome架构上进行了大刀阔斧的进化革新,力图将Naples打下的基业进一步扩展,以此成为进军数据中心市场核心应用的主力。 对于Rome,AMD的定位非常明确——大型数据中心里的主流应用平台。换句话说,Rome的进化势必是瞄准大规模虚拟化应用的。 而要想在这一领域建功立业,AMD需要在已有的内存带宽优势之上再获得两方面的成功:一是互联架构、二是单核心性能。

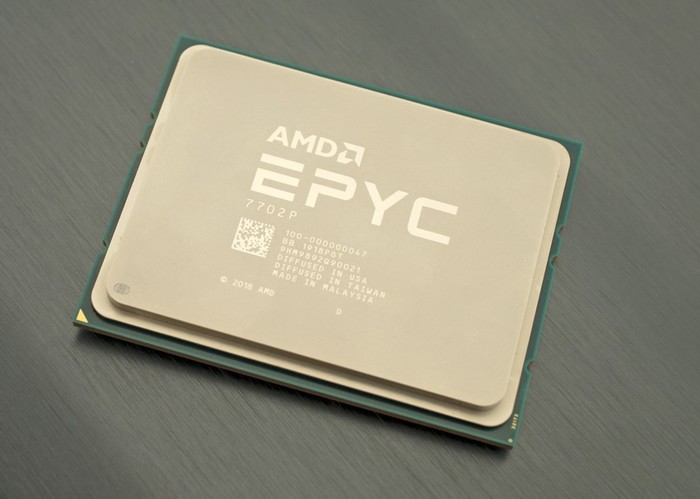

在互联架构层面,想要改变Naples的表现,AMD必须找到全新的途径。因为Rome的计算Die数量提升了一倍,达到了8个,不但互联复杂度大幅提高,继续增加每个晶片(AMD称之为Core Complex Die——CCD)上Infinity Fabric的数量还会增加晶片的面积。对于已经成为Fabless的AMD来说,这会带来成本的上升(尤其是在AMD已经为每4个Rome核心配备了16MB L3的情况下);要么损害利润率,要么损害性价比,都是得不偿失的做法。 然而,AMD借由更大胆的Chiplets设计找到了提升互联效率的全新方法。 通过在Core die之外构建一个功能更强大的IOD(IO die)并将每个CCD与IOD相连(这样,每个CCD上只需设计一个Infinity Fabric结构即可。其中的区别在于使用7nm制造的CCD由TSMC供应,成本更高,对良率也更敏感;而14nm工艺制造的IOD成本相对较低,工艺也较为成熟,GF即可提供。因此,把对功耗等7nm工艺优势项目不敏感的结构尽量放在成本更低的14nm IOD上就成为了更合理的选择),AMD可以有效减少socket间互联的复杂情况,大幅提升核心之间的互联效率。当然,这种相对简单的互联情况也更符合当前的企业软件设计风格,优化起来也更简单。 这张图片则更明确的说明了Rome相对于Naples在互联架构上的提升。相对于Naples,新的Rome只有两个NUMA域和两种NUMA距离 Naples的NUMA节点互联距离示意 Rome的NUMA节点互联距离示意 从上面的node(每个node相当于一个die,node 0即可理解为die 0)距离测试中,我们不难发现,虽然Rome与Naples同样有着三种node距离,但Rome的node外、socket内距离相比Naples有着明显的降低。严格的说,新的Rome也存在三种节点距离,但同一socket之上的两种距离10和12已经非常近似,因此可以看成是同一种节点距离;而这显然是设计一个独立的全功能IO die的最大好处之一。如果各个node之间发生通讯的概率相同,那么新的Rome架构在通讯效率上相比之前的Naples理论上会有11.4%的提升。 至于前面提到的:为什么会把NUMA1与NUMA3中有直连总线的情况也与需要跳转通讯的情况归为一类。由于所有通讯都需要借助独立在每个socket上的IO die来完成,所以是否有直连总线在实际通讯时也都需要两个socket上的IO die共同参与。这也与我们在测试中看到的“node 0与node 4-7通讯距离同为32”的测试结果相符。显然,无论是Rome还是更早的Naples,互联距离情况的简化都是非常明显的,这比Intel的总线连接情况要好不少。 在单核心性能上的终极进化 AMD在Rome上做出的进步: ·TAGE分支预测 ·2倍的指令缓存容量 ·重新优化的L1指令缓存 ·第三代地址生成单元 ·2倍的浮点数据并行位宽 ·几乎两倍的L1带宽 ·2倍的L3缓存容量 ·提升的数据预读取机制 互联架构的升级代表了Rome在集群作战时的战斗力,而单核心性能则代表Rome核心的单打独斗能力。这同样是AMD必须认真对待的领域,否则集群效率的提升及庞大核心数量所带来的优势很可能被单核心性能上的劣势消磨殆尽。 相对于Naples,Rome在核心性能上做出了非常多的进化。除了缓存部分的升级,Rome在整数及浮点的执行部分都做了加强。 从6发射变为7发射,AGU规模从2X14变为1X28,数量从2个变为3个;ALU数量不变但规模增加,更大的通用寄存器,更大的缓冲空间。 而在浮点计算部分,Rome则提供了翻倍的数据位宽、2倍的向量寄存器位宽,两倍的读取宽度,2倍的存储宽度并将双精度乘法延迟从4时钟周期将为3个。 与整数及浮点单元的全面加强同等重要的是,AMD还改进了Rome的分支预测机制,使之具备更高的命中率。 经过这一系列的加强,相对于上一代的Naples核心,Rome单核心取得了15%的IPC增强。这一点相当难得。 如果我们将隔壁厂的15%性能提升看做是“挤牙膏”,那么AMD这种全面从核心特性下手的15%性能提升则可以毫不夸张的算作“开闸泄洪”。 PCI-E 4.0带来的额外想象空间 PCI-E 4.0并非是刚刚诞生的标准,实际上这一标准早在2017年就已经完成制定,只不过彼时还只有IBM在自家的POWER 8上尝试支持这一标准。当年的Intel、NVIDIA等一众厂商对于这一标准并没有表现出太高的积极性。其中原因自然是PCI-E 3.0标准虽老,但尚能再战数年。 不过,时间到了2019年,PCI-E 4.0 16GT/s的性能前瞻性也开始渐渐找到了用武之地。随着更高性能的NVMe存储,200Gb接入层,针对更高数据吞吐量的新一代各类加速卡纷纷提上日程,人们对PCI-E 4.0的需求也开始迫切起来。 终于,AMD在IOD上集成了PCI-E 4.0控制器,并通过与GMI(用于处理器之间的互联,基本等同于Infinity Fabric)总线共享带宽可以对外提供128个PCI-E 4.0通道。 图中列出的是Rome支持的PCI-E通道组合形式。值得注意的是,每个处理器插槽会提供一个额外的PCI-E通道给BMC。 值得注意的是,在双路系统中,由于需要预留出足够的总线带宽用来进行CPU之间的数据互联,而这一互联总线与PCI-E控制器所使用的又同为Infinity Fabric,因此,典型的双路系统所能提供的PCI-E 4.0通道数仍为128个(还会有两个额外的PCI-E用来连接BMC),与单路系统相同。 而之所以要用“典型的”这个词,是因为AMD还为系统制造商提供了额外的选项。那便是降低Socket之间的互联带宽,并将更多的Infinity Fabric用来提供PCI-E 4.0。 这张来自STH的示意图能够很好的说明这一情况。典型的双路系统需要使用4个GMI来实现处理器之间的互联,每个GMI的带宽相当于一个PCI-E 4.0 x16。而在如图所示的双路系统构型中,两颗处理器之间只使用3个GMI互联,这就会释放出相当于两组PCI-E 4.0 x16的总线带宽,使的这一系统构型中,双路系统能够拥有的PCI-E 4.0通道数最高可以达到160个。 总体来说,AMD在Rome上提供了数量庞大且组合灵活的的PCI-E 4.0连接能力。这对于新一代异构计算、高吞吐量的扩展部件来说都是一件好事,服务器的网络、AI、存储、处理加速能力都将因此获得提升。 AMD EPYC 7742服务器测试——测试平台 测试使用的是目前最顶级的EPYC 7742双路处理器,满血64核,基础频率2.25GHz,加速频率3.4GHz,拥有256MB三级缓存,TDP功耗225W;官方售价每颗6950美元,仍旧比至强8200系列的最顶级型号要便宜不少。 BIOS中的CPU信息 BIOS中的内存信息 BIOS中的内存容量 此次评测的服务器配置如下: (AMD服务器无需芯片组) 不出意料的性能惊喜 Linpack测试:

首先,在Linpack 2.2测试中,双路EPYC 7742处理器在NPS(NUMA nodes per socket)=4并关闭超线程之后能够取得4.64TFlops。从经验来看,这一性能虽然还无法与9200系列中的顶尖型号比肩,但已经可以超越8200系列产品了。而这对于AMD来说则是一个巨大的进步。毕竟Intel的9200系列目前只有Intel定制的水冷整机产品,而没有OEM、ODM产品。 2、TPC-C测试

在NPS=4的情况下开启7742处理器的超线程功能。利用MySQL 8.0.18自带的TPC-C对服务器整体进行测试。首先利用MySQL自带数据生成工具生成10000个data warehouse,数据准备好后开启128个线程对数据库进行持续6小时的读写操作,并且每10秒对数据进行记录。 最终,在长达6小时的马拉松测试中,采用双路AMD EPYC 7742处理器的服务器最终得分为32875TPM-C。而在相同配置下,将同时操作的线程数降低为64个,成绩将会提升至34969TPM-C。对于这个体量来说的data warehouse,这一成绩可谓亮眼。 AMD EPYC的现在与未来

Rome平台Core Complex Die Rome平台IO Die 对于AMD来说,Rome平台能够在性能上取得这样的成绩实属不易,但性能的强大对于AMD以及EPYC系列来说也仅是成功的开始。 在8月的Rome发布现场,AMD CEO苏姿丰博士曾出豪言:要将竞争带回数据中心市场。 而服务器市场的竞争并不仅是性能上的,更是市场话语权、用户认可程度和领导力上的。现在,EPYC在性能上获得与Intel一较高下的能力之后,重回数据中心市场竞争的AMD正逐渐赢得用户的认可,一点点地去争取更进一步的话语权,并凭借一系列的创新重建领导力。这些也都是AMD在产品之外,需要慢慢下的功夫。 第一代Naples为AMD带来了入场券和关注度,第二代Rome则为AMD带来了与Intel在主流市场同台竞技的实力。接下来,AMD仍需继续发力产品,下功夫打造产业链,并以自身独特的价值持续为用户带来业务和应用方面的更多可能,才能够回归巅峰,争取一个全新的未来。 而这样一个未来值得用户与我们共同期待。 |

正在阅读:意料中的惊喜 64核第二代EPYC服务器性能测试体验意料中的惊喜 64核第二代EPYC服务器性能测试体验

2020-01-09 16:04

出处:PConline原创

责任编辑:sunziyi