太平洋科技 企业站

只使用3000个GPU就能训练一个ChatGPT?

佚名

整合编辑: 王珂玥

发布于:2024-01-08 08:24

佚名

整合编辑: 王珂玥

发布于:2024-01-08 08:24

|

橡树岭国家实验室的研究人员在Frontier超级计算机上训练了一个与ChatGPT大小相当的大型语言模型(LLM),只需要37.888个GPU中的3,072个就可以完成。该团队发表了一篇研究论文,详细介绍了他们是如何实现这一壮举的,以及他们在此过程中面临的挑战。 这台Frontier超级计算机配备了9472个Epyc 7A53 cpu和37888个Radeon Instinct GPU。然而,该团队只使用了3072个GPU来训练一个具有1万亿个参数的LLM,使用了1024个GPU来训练另一个具有1750亿个参数的LLM。 该论文指出,训练如此大型的LLM的关键挑战是所需的内存量,至少为14TB。这意味着需要使用多个带有64GB VRAM的MI250X.但这引入了一个新问题::并行性。在LLM上投入更多的GPU需要越来越好的通信才能有效地使用更多的资源。否则,大部分或全部额外的GPU能力将被浪费掉。 研究报告深入研究了这些计算机工程师是如何做到这一点的细节,但简短的版本是,他们迭代了像Megatron-DeepSpeed和FSDP这样的框架,改变了一些东西,以便训练程序在Frontier上运行得更优。最后,结果非常令人印象深刻——弱扩展效率达到100%,这基本上意味着随着工作负载的增加,更多的GPU被尽可能有效地使用。 同时,1750亿参数LLM的强缩放效率略低,为89%,1万亿参数LLM为87%。强可伸缩性指的是在不改变工作负载大小的情况下增加处理器数量,根据Amdahl定律,这往往是高核心数量变得不那么有用的地方。考虑到他们使用了多少GPU,甚至87%也是一个不错的结果。 然而,该团队注意到在Frontier上实现这种效率的一些问题,指出“需要更多的工作来探索AMD gpu上的高效训练性能,而ROCm平台是稀疏的。”正如论文所说,这种规模的大多数机器学习都是在英伟达的CUDA硬件软件生态系统中完成的,相比之下,AMD和英特尔的解决方案并不发达。当然,这样的努力将促进这些生态系统的发展。 尽管如此,世界上最快的超级计算机仍然是Frontier,它的硬件全是AMD的。第二名是Aurora,它采用的是纯英特尔硬件,包括GPU,尽管目前只有一半的硬件用于基准测试。英伟达GPU为第三快的超级计算机Eagle提供动力。如果AMD和英特尔想要保持目前的排名,这两家公司将需要赶上英伟达的软件解决方案。 原文《Frontier trained a ChatGPT-sized large language model with only 3.000 of its 37.888 Radeon GPUs — the world's fastest supercomputer blasts through one trillion parameter model with only 8 percent of its MI250X GPUs》 |

原创栏目

企业视频

IT百科

网友评论

聚超值•精选

-

- Apple/苹果2023款Mac mini迷你主机【教育优惠】M2(8+10核)8G 256G 台式电脑主机MMFJ3CH/A

- 券后省400

-

¥3299.0

¥3699.0

- 联想笔记本电脑小新Pro14超能本 高性能标压英特尔酷睿i5 14英寸轻薄本 16G 1T 2.8K高刷护眼屏 灰

- 券后省10

-

¥4789.0

¥4799.0

- 奋达(F&D) E300电脑音响有线小音箱台式低音炮家用桌面笔记本usb游戏音箱迷你长条电竞炫彩灯光电脑音箱 E300BT电脑多媒体音箱蓝牙音箱

- 券后省60

-

¥69.0

¥129.0

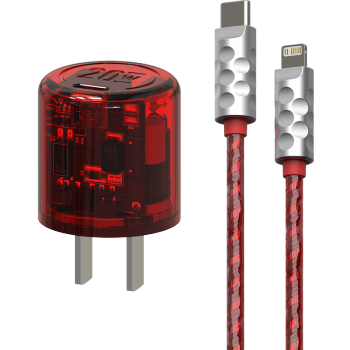

- 黑鱼 (mfish) 电力蘑菇氮化镓苹果充电器20W快充头iphone充电器USB-C手机充电器套装适用苹果华为 红色_电力蘑菇单头20W(提速400%)

- 券后省10

-

¥89.0

¥99.0

- vivo X100 Pro 12GB+256GB 星迹蓝 蔡司APO超级长焦 蓝晶×天玑9300 5400mAh蓝海电池 自研芯片V3 手机

- 券后省10

-

¥4989.0

¥4999.0

-

- HKC 24.5英寸1080P CSGO吃鸡高清屏幕 高刷台式电脑 广色域 可壁挂 电竞游戏显示器 VG255SE/100Hz/IPS面板

- 券后省30

-

¥669.0

¥699.0

- 星系源铝合金充电宝5000毫安双口12w充电宝适用苹果14pro13iPhone12pro11xs8移动电源金属手感轻薄小巧

- 券后省12

-

¥17.9

¥29.9

- 荣耀Magic Vs2 超轻薄机身 零风险调光护眼双屏 5000mAh超长续航 5G 折叠屏手机 16GB+512GB 冰川蓝

- 券后省20

-

¥7679.0

¥7699.0

- 小度智能屏X9 云台360度摄像 红外夜视 视频通话 蓝牙音箱触屏音响 家庭影院 小孩陪伴老人 送礼 礼物

- 券后省20

-

¥629.0

¥649.0

- 浩瀚卓越(hohem)m6 kit手机云台稳定器手持防抖AI跟拍正交三轴直播拍摄照神器视频 M6标配【含收纳包 三脚架 充电线*3】

- 券后省100

-

¥1049.0

¥1149.0

-

- 凯利科(KLKE) 电竞刷新率电脑显示器超薄微边框高清hdmi游戏办公设计家用广视角IPS 【24曲面+100hz+1080p】

-

¥379.0

¥389.0

- 联想拯救者R9000P 16英寸游戏笔记本电脑(8核16线程R7-6800H 16G 512G RTX3060 2.5k 165Hz高色域)灰

- 券后省10

-

¥9989.0

¥9999.0

- 戴尔(DELL) S2722DC升级版27英寸2K 75Hz IPS电脑显示器屏幕 65WUSB-C S2722DC USB-C 内置音箱 官方标配

- 券后省50

-

¥1749.0

¥1799.0

- AMD 锐龙五代 盒装处理器 带VEGA核显 7nmCPU AM4接口 R7 5700G(带核显)

- 券后省30

-

¥1169.0

¥1199.0

- Apple/苹果 iPhone 15 Pro (A3104) 128GB 原色钛金属 支持移动联通电信5G 双卡双待手机

- 券后省550

-

¥6849.0

¥7399.0

-

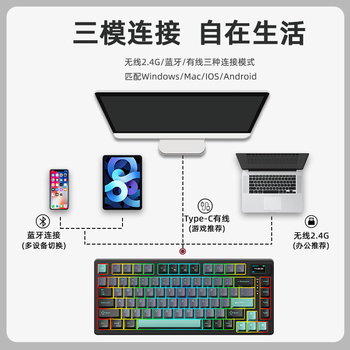

- 魔咖3075机械键盘diy屏幕无线2.4g蓝牙gasket热插拔pbt侧刻键帽

- 券后省100

-

¥149.0

¥249.0

- ikbc机械键盘无线办公键盘cherry樱桃轴有线键盘笔记本电脑外接键盘电竞游戏键盘 R300TKL蓝光有线87键 红轴

- 券后省30

-

¥149.0

¥179.0

- 罗马仕适用苹果15数据线iPhone14充电线快充13promax手机11充电8plus闪充PD20W充电线iPad平板2米XR

- 券后省2.1

-

¥10.5

¥15.6

- 哈曼卡顿(Harman/Kardon)水晶四代 全新一代桌面蓝牙音箱 电视电脑音响 新款 SoundSticks 4代 白色

- 券后省100

-

¥1641.0

¥1741.0

- vivo【全新未激活】vivo X100蔡司红外防水护眼屏5G全网双卡X100手机 落日橙 16GB+256GB

- 券后省10

-

¥3718.0

¥3728.0

佚名

佚名

硬件编年史

硬件编年史