太平洋科技 企业站

VMware Private AI解决方案详述一:VMware Private AI入门

安浦(编译)

整合编辑:王珂玥

发布于:2024-04-01 09:32

安浦(编译)

整合编辑:王珂玥

发布于:2024-04-01 09:32

|

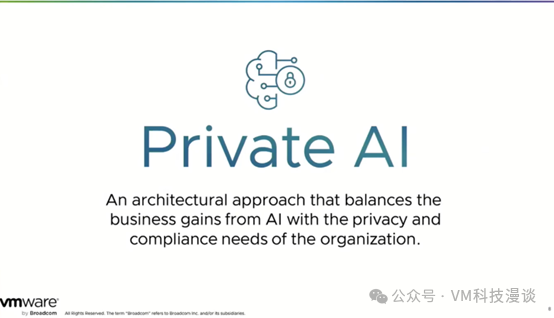

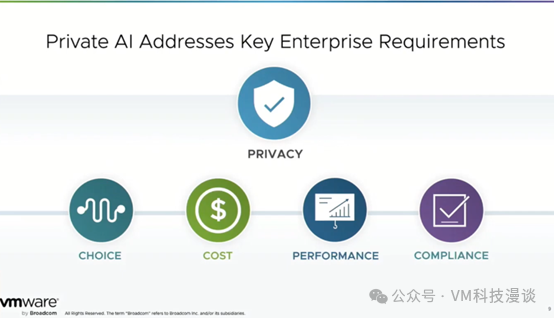

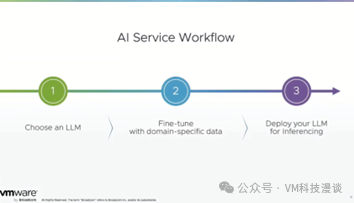

本文编者为VMware中国资深架构师安浦,基于2024年2月21日VMware by Broadcom 在 Tech Field Day 活动现场AI Field Day 4主题的系列演讲整理。演讲嘉宾为Chris Wolf,Senior Director of Engineering, AI and Advanced Services,VMware By Broadcom。 内容摘要 -本演讲介绍了VMware Private AI理念的核心原则及相关解决方案的常见应用场景。 -Private AI是一种新的架构方法,旨在保障组织商业利益的同时,实现组织与个人隐私及合规需求的平衡。 -AI的数据主权、伦理与隐私问题,以及安全的访问控制至关重要。 -Private AI应具备选择的灵活性与适应性,组织需要权衡成本、性能与合规性,避免被单一垂直AI技术栈所绑定。 -关注AI的特定模型微调和检索增强生成(RAG)等技术。 推动Private AI领域的生态环境发展,VMware寻求与广大客户及合作伙伴进行更深入的合作关系,VMware并不试图解决所有问题,只在自己最擅长的领域中,为用户提供明确的价值。

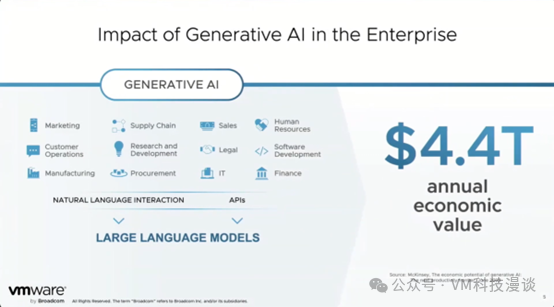

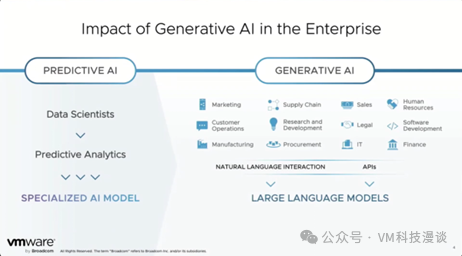

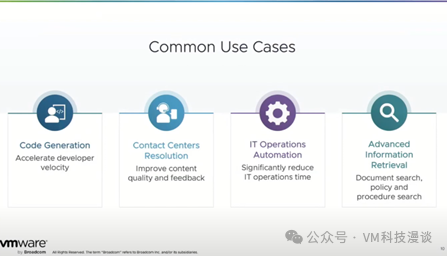

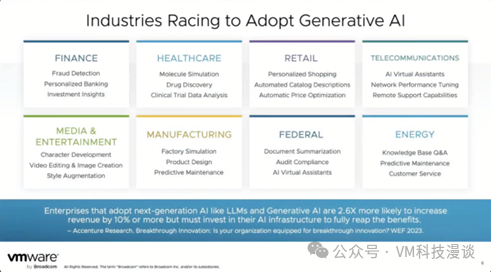

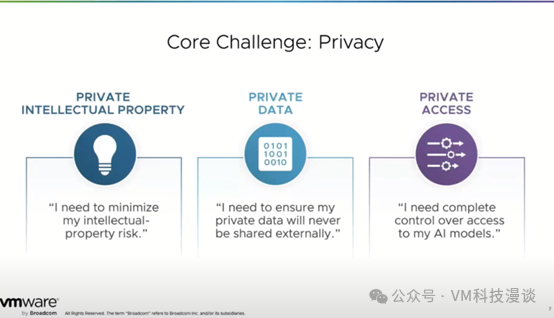

前言 多年来,应用创新领域经历了巨大的变革。从PC应用开创新机遇,到业务生产力的提升,再到Web应用真正改变游戏规则,乃至移动应用的崛起。现在,我们迎来了AI应用的崭新时代,这势必将产生同样深远的影响,引领我们迈向未来。 麦肯锡对生成式AI的年度潜在经济价值的预测,大约为4.4万亿美元。这对于整个行业来说是一个巨大的机遇,正在加速推动行业变革和转型。 当我们深入研究AI生态系统时,会发现它涉及到应用、移动设备、数据服务以及计算基础设施等多个方面。此外,还有从生成式AI中获得的派生业务价值,这也将是整个生态系统不可或缺的一部分。 AI的应用场景 AI并非新鲜事物,VMware已经与一些组织合作多年以深入研究AI。很长时间以来,AI在诸如欺诈检测等专业领域的应用已经十分广泛。 那些已经拥有AI专业知识的组织,如INF金融服务,能够迅速转向采用大模型的生成式AI。当前,各行各业都有AI的应用场景。以VMware自身为例,我们在营销领域的一个早期应用场景中,运用基于SaaS的AI服务创作营销内容。我们与两家不同的公司合作,发现效果显著,这成为我们早期推进的一个领域,另外我们在软件开发方面也取得了一些进展,开始看到更多AI应用场景的出现。 每个人都有这样的应用场景,都希望减少对支持团队或helpdesk的依赖。这不仅具有明显的业务价值,而且通过大模型还可以取得相当显著的效果。在VMware内部运行的大模型,能够针对内部文档WIKI进行查询,甚至为用户创建围绕不同产品集成的代码示例,所有这些都构建于一个开源大模型基础之上。 在全球范围内也有很多相对一致的AI应用场景,比如零售业多年来一直在使用计算机视觉来检测自助结账时的盗窃行为。去年底,我们与一家零售商合作,帮助他们在所有门店的VMware技术栈平台上运行关键AI应用。他们正探索一种计算机视觉应用,通过安装在走廊上的摄像头来识别那些在走廊里逗留过久的人,因为这很可能意味着这个人需要帮助。这套系统本地化部署在多个基于VCF的VxRail上运行,因此不会遇到任何推理延迟。当需要采取行动时,它会向相关人员发送被称为“催动”的短信通知。告知他们前往哪个走廊,指引他们找到顾客并为其提供帮助。通过评估这项技术的影响,该用户发现采用此技术的商店销售额会有显著提升。 这种可衡量的投资回报令人振奋。这项技术正逐渐受到关注,并被多个领域尝试应用。常见的应用场景包括客户服务、企业知识搜索等。例如,有很多企业都在尝试通过大模型技术来加速处理其内部文档,无论是销售合同还是法律文件等。 AI的数据主权、伦理与隐私问题 我们注意到全球很多国家和地区的AI发展势头正在不断加快,与此同时,关于组织数据主权的问题关注度也正在不断提高,这也是我们接下来在Private AI部分将要探讨的内容。目前,许多政府正加大力度制定AI伦理和良好使用规范。例如,欧盟在这方面正在采取行动,而美国国家标准与技术研究院(NIST)也发布了一些相关指南。因此,我们可以看到在这方面正逐渐展现出一定的成熟度。 AI确实引发了广泛关注,并涉及一些复杂的问题。许多人担心自己的知识产权被用于训练可让竞争对手受益的模型。在考虑这个问题时,一个零售业CIO与我们分享了他的经历。他曾使用基于SaaS的AI服务来处理客户需求并生成邮件。然而,他后来发现竞争对手的邮件使用了与他相同的语言表达,这意味着他们可能使用了相同的AI服务。 因此,我们需要重新思考这个问题。我们希望能够利用历史数据和与客户的沟通方式,调整模型以捕捉我们的独有特征。在VMware环境中,保护关键知识产权——源代码的隐私性至关重要。为了确保源代码的隐私性,我们采用了一些开源技术,如StarCoder,以避免数据共享和外部隐私泄露。 这也符合数据主权的要求,政府在这方面也提出了相关规定。这也是当前众多客户的一个关键关注点,因为他们希望保持对数据的控制,并避免将数据转换为专有数据格式,以便利用AI的优势。这样做的好处是,当更好的解决方案出现时,他们可以更容易地进行更改,而不会面临高昂的成本。 Private AI确保安全的访问控制 在AI的大规模应用中,访问控制是一个必须解决的棘手问题,实事求是的讲,在技术层面,当前业界还未达到应有的水平。以检索增强生成(RAG)等基于搜索的生成式AI应用场景为例,运行一个使用提升权限收集数据、填充向量数据库的软件轻而易举。但这里的问题是,若我们使用这些提升权限收集的数据,随后一个权限较低的用户开始对该模型进行查询,这就相当于为黑客打开了一扇后门,风险极高。 在实际操作中,如美国联邦政府等机构,对安全许可级别的要求极为严格。若存在不同的安全许可或级别,每个级别都需使用不同的模型。甚至在同一个模型或聊天接口内,也不允许出现任何数据中毒的风险。这也促使我们更加倾向于采用Private AI方案。 我们认为,Private AI将是一种行业趋势,且不仅限于私有云。在AWS的虚拟私有云上运行Private AI同样可行,这样既保留了AI的业务价值,又满足了组织的隐私和合规需求。切记,在AI的应用中,保持数据控制、隐私和合规性至关重要。 为确保数据特权级别,可以采用为不同级别的数据训练单独的模型的方式。这意味着每个模型都是在相应的访问权限级别上进行训练的。因此,我们可能会训练多个模型,并在多个模型之间进行推理。对于拥有多个安全级别的公司,如情报服务等,这种方法已成为他们的实际选择。尽管许多人仍在摸索中,面临未知的不确定性,但这确实是目前最可行的方式。 回顾早期虚拟化的发展历程,当时组织面临着PCI合规性工作负载的挑战。为确保通过合规性审计,一种常见的解决方案是将PCI合规性工作负载放置在专用的物理集群上,实现物理隔离。在AI领域,我们也看到了类似的方法。尽管这种方法可能被视为过于保守,但组织不希望出现混乱,这是其背后的核心理念。 成本与性能的考量 成本是一个极为关键的考量因素。在我们所观察到的Private AI领域,相较于现有的某些公共AI服务,其成本可能减少高达三分之一。我们已进行了一些基准测试,并与第三方合作,以收集这方面的数据,进一步验证这一点,甚至可能基于此调整我们的一些假设。当能够开始为AI基础设施带来自身的成本优化,并将其保留在企业内部时,对企业来说,就意味着蕴藏巨大的降本增效的潜力。性能同样至关重要,无论应用于虚拟环境还是非虚拟环境,当然,前提是必须确保满足合规性需求。 选择的灵活性与适应性至关重要 除了隐私之外,我们认为选择的权利同样重要。这意味着用户可以更加自由的选择在平台上运行的软件,以及可能使用的不同AI加速器的硬件。采用垂直集成的解决方案,如果局限于单一AI模型,单一软件堆栈和单一硬件堆栈去匹配所有的场景,完成所有的任务,是不切实际的。 我们希望能够保持选择最佳方案的能力,利用多种不同的软件技术,这些技术更具有应用场景导向。我们不能仅仅将自己锁定在单一的垂直技术栈中,不能将自己局限于限制数据、控制和模型选择灵活性的解决方案中,无论是商业的、开源的还是云端的。一个具备广泛适应性的解决方案至关重要,这也是很多用户的关键要求。 关于模型微调与检索增强技术(RAG) 对于AIGC的实际应用,典型的工作流程是先选择一个LLM,并使用特定领域的数据对其进行微调,然后,部署该LLM以进行推理。很多时候,人们认为AI训练需要数十到数千个GPU,但实际上并不完全如此。例如,对与某些小参数量的模型微调,可能使用两个A100.只需半天时间就够了。在运行推理工作负载时,通常只会消耗一小部分GPU资源,而这正是虚拟化等技术开始发挥重要作用的地方。推理是一项全天候进行的工作负载,是一个持续的过程,而训练往往是间歇性的活动,因此,考虑整个架构时,不应只将注意力集中在训练层面上,也需要关注到推理层面的技术实现。 对RAG来说,意味着可能并不需要针对模型进行微调。我们可以利用基础模型,例如我们当前使用的WizardLM这一开源模型。由于模型拥有足够的参数,它能够创建有效的查询,并从数据库中提取所需信息。RAG采用向量数据库技术,使用户可以利用数据库中对象组的相似性,帮助模型确定搜索目标。 通常,在RAG架构中,当获得结果时,它还会提供模型如何得出该答案的链接或参考。RAG极大地简化了整个流程,降低了设置和获取AI价值和好处的专业知识要求。这是我们当前重点关注的领域之一,因为几乎任何行业都可以找到RAG的应用场景。 Private AI领域的生态合作 在制定Private AI战略的过程中,我们与整个行业进行了广泛的验证,与超过40家的不同客户进行了合作,这些客户已经拥有各式各样的AI应用场景。此外,我们还借助第三方与200个不同的客户就这些需求进行了沟通,从而能够汇总足够数据,形成我们的初始立场。而这一切不仅仅局限于VMware当前的客户群体,也包括很多非VMware的客户,以避免产生确认偏见。我们希望能从绝对客观的角度看待创新,探索可能忽视的方面,确保走在正确的道路上。 在Private AI的技术实现方式上,并没有一个固定的标准答案。用户可以使用像NVIDIA NeMo软件这样的模型服务,这是客户常用的一种方式。用户还会使用许多MLOps工具,其中许多与VMware生态系统中的合作伙伴有关。我们也在内部进行了一些开发工作,为我们的解决方案堆栈提供更多这样的能力。此外,我们还与一些合作伙伴展开合作。例如,我们可以使用IBM Watsonx进行模型服务和管理,并在我们的技术栈上运行。 重点是,在我们为生态系统增加价值的地方,寻求更深入的合作伙伴关系。我们并不试图解决所有问题,实际上,我们的合作伙伴也更喜欢这种方式,因为我们不是他们的直接竞争对手。我们只在我们擅长的领域中,为用户提供明确的价值! VMware AI解决方案相关信息链接 Artificial Intelligence Solutions | VMware AI: https://www.vmware.com/artificial-intelligence.html VMware's Approach to Private AI: https://news.vmware.com/technologies/vmware-technology-private-ai Deploying Enterprise-Ready Generative AI on VMware Private AI: https://core.vmware.com/resource/deploying-enterprise-ready-generative-ai-vmware-vmware-cloud-foundation 关于AI Field Day AI Field Day是线下小组研讨会形式,嘉宾演讲过程中穿插着大量与参会者的互动讨论,为了便于读者阅读和理解,在原演讲视频录音内容的基础上进行了适度的裁剪修改,以及部分内容先后顺序的调整。

来源: VM科技漫谈 by:安浦(编译) |

原创栏目

企业视频

IT百科

网友评论

聚超值•精选

-

- 任天堂(Nintendo)Switch OLED日版/港版游戏机续航加强版ns体感掌机便携家用主机 OLED日版白色64GB保税(赠2年VIP会员)

- 券后省10

-

¥1938.0

¥1948.0

- 适用华为P60proP30/P40/P50钢化膜mate60/30/40/50nova6/7/8/10/11/12荣耀90/70/80水凝x50手机8x9x贴膜x40

- 券后省3

-

¥8.8

¥11.8

- 闪迪(SanDisk)256GB SD内存卡 至尊高速版读速100MB/s 数码相机 摄像机存储卡 支持高清视频

- 券后省10

-

¥179.0

¥189.0

- 西部数据(WD)1TB 笔记本SSD固态硬盘 M.2 SN850X PCIe4.0 2280 NVMe 游戏电竞电脑扩展硬盘

- 券后省30

-

¥739.0

¥769.0

- 官方旗舰店罗技gprowireless无线有线双模电竞游戏鼠标狗屁王GPW

- 券后省400

-

¥499.0

¥899.0

-

- ulanzi优篮子 J12(type-c版)一拖二无线领夹麦克风收音麦小蜜蜂收音器专业vlog拍视频户外采访录音直播

- 券后省20

-

¥209.0

¥229.0

- 铁威马(TERRA MASTER) F4-423 8g 企业四盘位高配NAS网络存储 双2.5G网口 F4-423-8G标配-空机

- 券后省200

-

¥1799.0

¥1999.0

- 小天才儿童电话手表Q1R长续航防水GPS安全定位智能语音通话手表礼物数码 Q1R 桃粉

- 券后省30

-

¥368.0

¥398.0

- 杰士(Klipsch)the Three III 无线蓝牙音响 HIFI音响 重低音发烧古典音响电脑音响 可直连唱机 胡桃木色

- 券后省200

-

¥2999.0

¥3199.0

- Aqara绿米联创智能摄像机G3网关版 人脸识别手势识别 智能家居远程控制

- 券后省10

-

¥779.0

¥789.0

-

- 【新品】华为手表WATCH GT4运动智能电话手表心脏早搏房颤血氧检测健康提醒蓝牙商务男女手环官方旗舰款46mm

- 券后省293

-

¥1258.0

¥2251.0

- Apple/苹果 iPad mini(第 6 代)8.3英寸平板电脑 2021款(256GB WLAN版/MK7V3CH/A)星光色

- 券后省200

-

¥4999.0

¥5199.0

- ThinkPad联想笔记本电脑ThinkBook 16+ 2024 AI全能本 英特尔酷睿Ultra5 125H 16英寸 32G 1T 2.5K RTX4060

- 券后省10

-

¥8989.0

¥8999.0

- 拜雅(beyerdynamic) DT770 PRO 头戴式 专业录音 封闭式监听耳机 80欧低阻黑色特别版

- 满1399减150

-

¥1349.0

¥1399.0

- 夏科电脑键盘鼠标套装有线台式笔记本办公专用静音无声打字外接usb家用商务电竞游戏真机械手感键鼠三件套

- 券后省2.4

-

¥13.4

¥17.8

-

- 中国联通 手机卡流量卡不限速全国通用纯上网卡奶牛热点长期套餐校园卡大王卡新惠卡 长期超龙卡59包269G通用+100分钟长期可选号

- 券后省4

-

¥1.6

¥5.6

- AMD 锐龙五代 盒装处理器 带VEGA核显 7nmCPU AM4接口 R5 5600G(带核显)

- 券后省30

-

¥819.0

¥849.0

- 拾光坞N3云盘星光版V/NAS私有云网盘/云存储/离线下载/docker/影视墙/低功耗 星光版- V 黑色

- 券后省102

-

¥377.0

¥479.0

- 唯卓仕23/33/56mm F1.4索尼口自动对焦镜头APS-C画幅适用E卡口A6400 A6700微单相机大光圈人像定焦镜头 AF 23/1.4 E 官方标配

- 券后省30

-

¥1699.0

¥1729.0

- 华硕 追影13/14代i7 14700KF吃鸡永劫无间直播设计师电竞游戏台式电脑主机diy组装整机 规格三丨新i7 14700KF/RTX4060

- 券后省800

-

¥7599.0

¥8399.0

安浦(编译)

安浦(编译)

硬件编年史

硬件编年史