太平洋科技 企业站

VMware Private AI 方案详述三:VMware Private AI Foundation with NVIDIA

安浦(编译)

整合编辑:王珂玥

发布于:2024-04-16 09:01

安浦(编译)

整合编辑:王珂玥

发布于:2024-04-16 09:01

|

本文编者为VMware中国资深架构师安浦,基于2024年2月21日VMware by Broadcom 在 Tech Field Day 活动现场AI Field Day 4主题的系列演讲整理。演讲嘉宾为Justin Murray,Product Marketing Engineer, VMware By Broadcom。

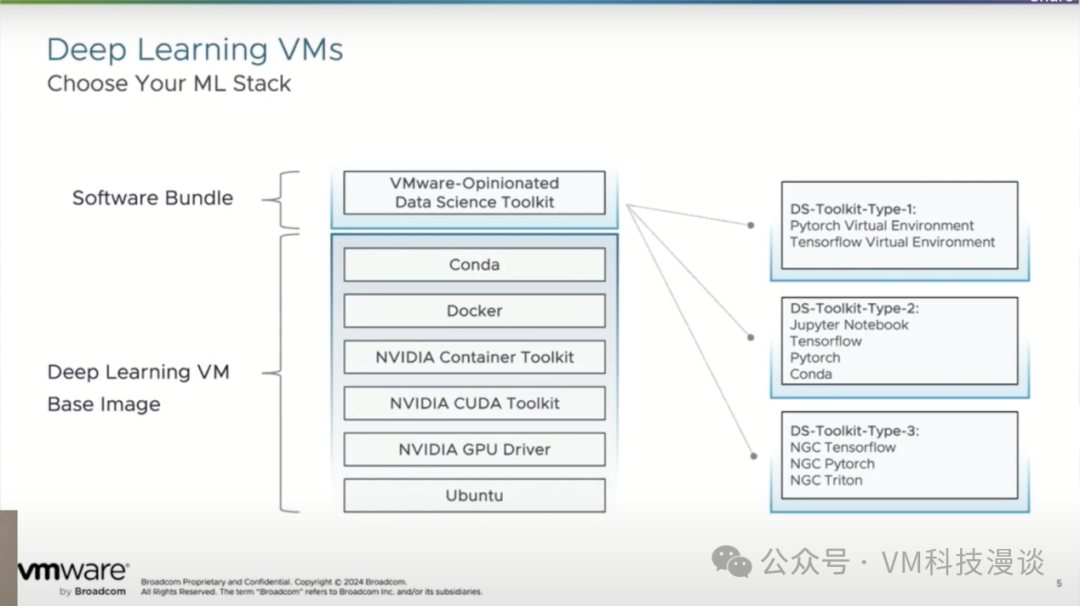

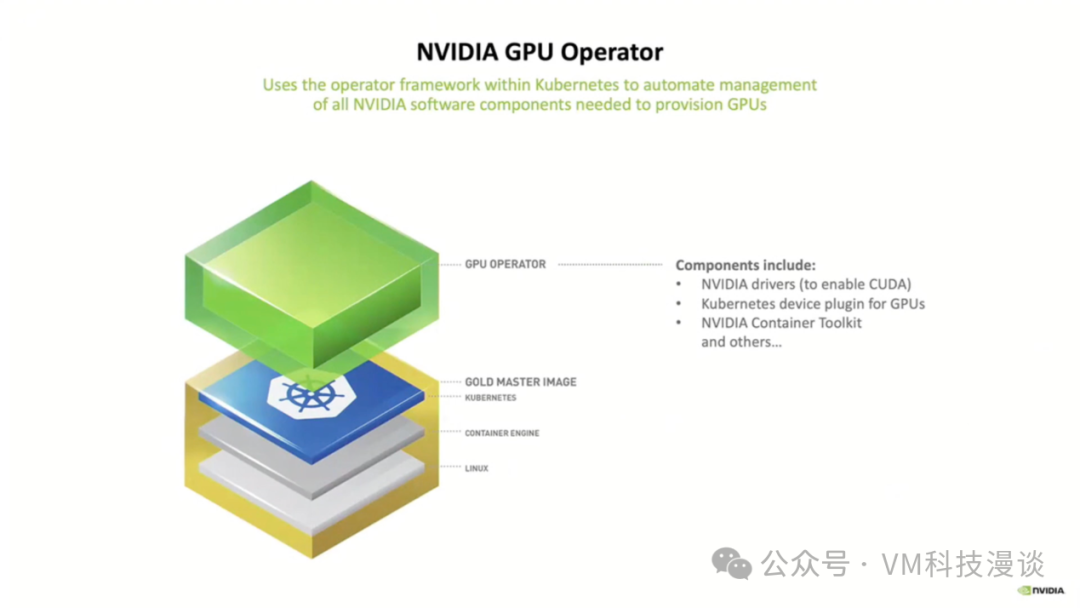

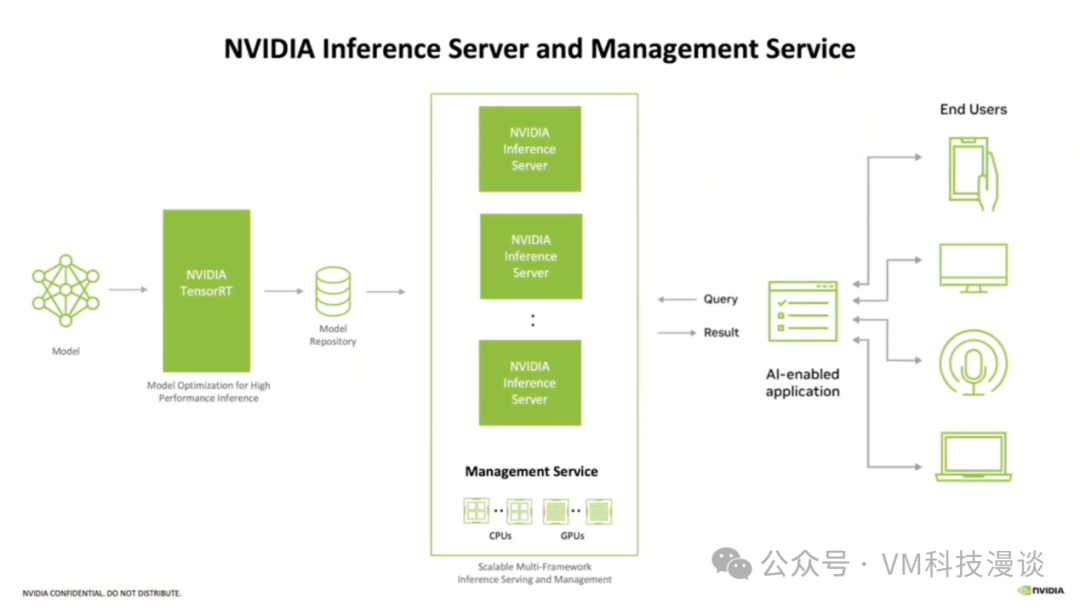

VMware Private AI Foundation with NVIDIA是一个专注于为企业提供隐私、安全和控制为重点的生成式AI应用程序解决方案。 平台构建在VMware Cloud Foundation之上,特别针对AI进行了优化,并配备了NVIDIA NeMo用于定制和部署生成式AI模型。 集成了AI工具,让企业能够定制模型并在数据附近运行生成式AI应用程序,同时解决了企业在数据隐私、安全和控制方面所面临的挑战。 结合定制框架、防护工具包、数据筛选工具和预训练模型,为企业提供了简单、经济高效且快速采用生成式AI的途径。 为数据科学家提供便捷访问工具的自助服务目录、在vCenter界面中监控GPU的功能,以及预装了数据科学工具包的深度学习虚拟机。 向量数据库,特别是PGVector,对于RAG至关重要。RAG将数据库技术与大语言模型相结合,以提供最新和私密的查询响应。该解决方案的设计目标是让数据科学家和为他们服务的管理员都能轻松使用,重点在于简化AI应用程序的部署和管理流程。 该解决方案与各种向量数据库兼容,能够与私有数据一起使用,尤其适用于银行等行业。目前全球已有超过60家客户在产品正式发布前对这种架构表示了浓厚的兴趣。 演讲正文 VMware Private AI Foundation with NVIDIA是一款全面集成的解决方案,结合了NVIDIA的生成式AI软件和算力加速功能,构建在VMware Cloud Foundation之上,并特别针对AI进行了优化。 整体架构简介 这个架构大致可分为四个层次。在顶部是可选择的模型,而在底部,各大硬件供应商已经投入资源,为NVIDIA AI Enterprise编写了部署指南,该NVAIE解决方案软件包已经存在了两年。Private AI Foundation with NVIDIA则基于VMware Cloud Foundation而构建,特别针对大模型和生成式AI,对其做了进一步的优化和补充。 其中,蓝色层是VMware提供的,专门为大模型和生成式AI设计的附加VCF扩展组件。这一层包括深度学习虚拟机、向量数据库PGVector(这是RAG的核心)、自助服务目录等关键组件。自助服务目录是方案的灵魂,它让数据科学家能够以极简的方式快速启动他们的工具和平台,无需担心网络或磁盘空间。这与公有云提供的LLM类似,也是有意为之的设计。此外,蓝色层还提供了GPU监控功能,通过vCenter界面,管理员可以实时查看数据科学家是否正在使用GPU,以及他们是否真正需要所声称的GPU资源。 在蓝色层之上是绿色的NVIDIA层。这里汇聚了NVIDIA众多AI相关创新产品。如Triton推理服务器用于将模型部署到生产环境,它是一个多线程、多模型的应用服务器,每个GPU类型一个,通过gRPC API呈现。GPU操作员将涉及这些操作工作,而Kubernetes在这里扮演着至关重要的角色。当进入生产阶段时,NeMo框架将发挥关键作用。神经网络是核心,Transformer也是其中的一部分。TensorRT作为模型的优化编译器,能够将模型从32位精简到8位,以便在生产环境中更高效地运行。 VMware Private AI Foundation with NVIDIA与开源语言模型兼容,在演示中会看到如何从Meta下载Llama 2模型,NVIDIA也有他们自己的大语言模型,如高端模型 Megatron,其中一些甚至针对特定的GPU进行了定制。后面的演示中,将会使用其中一个模型。

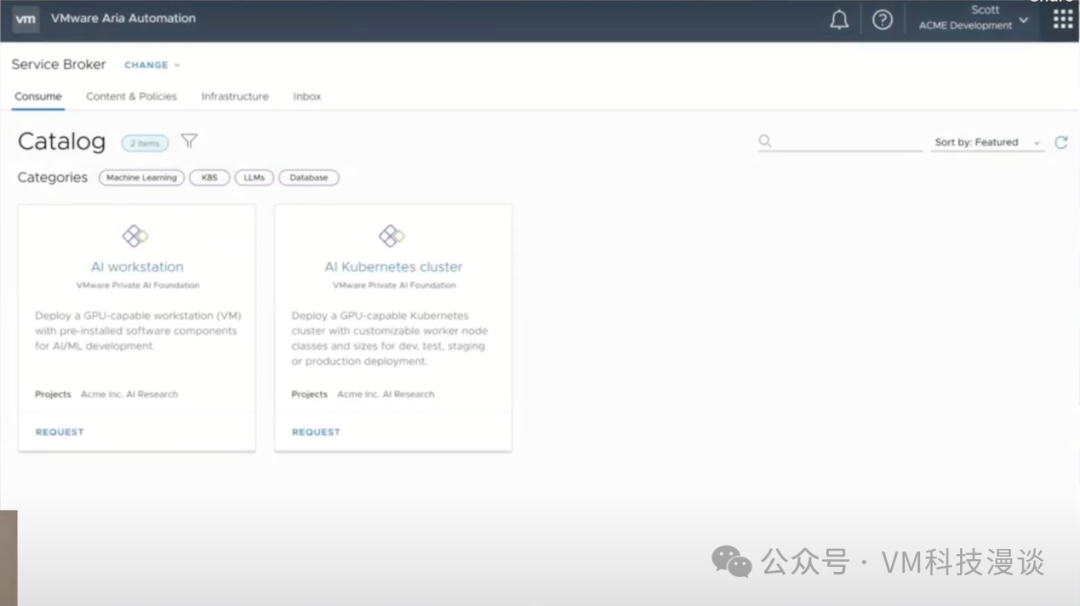

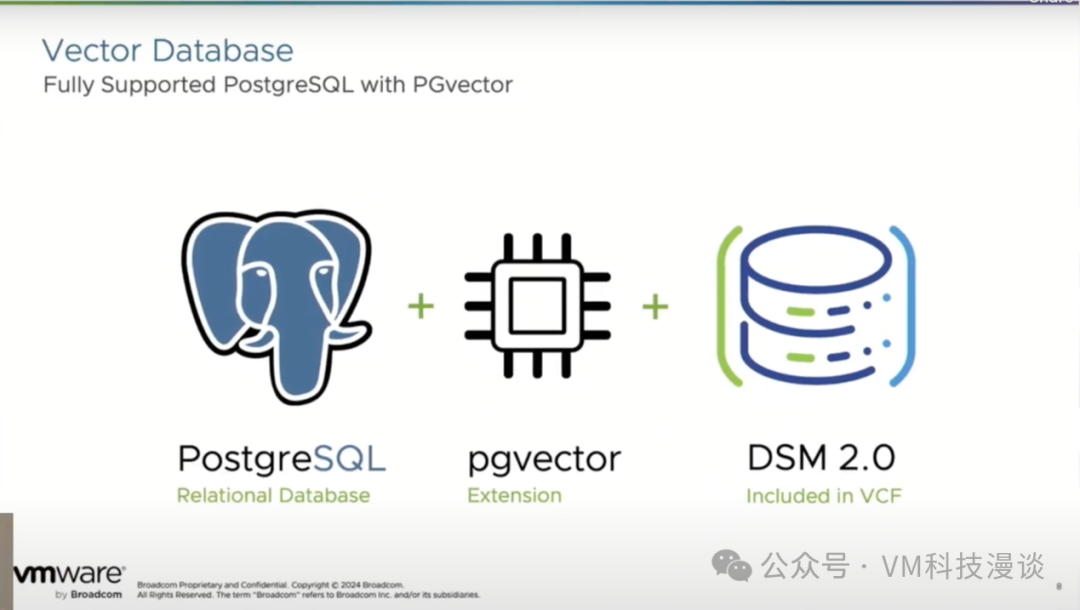

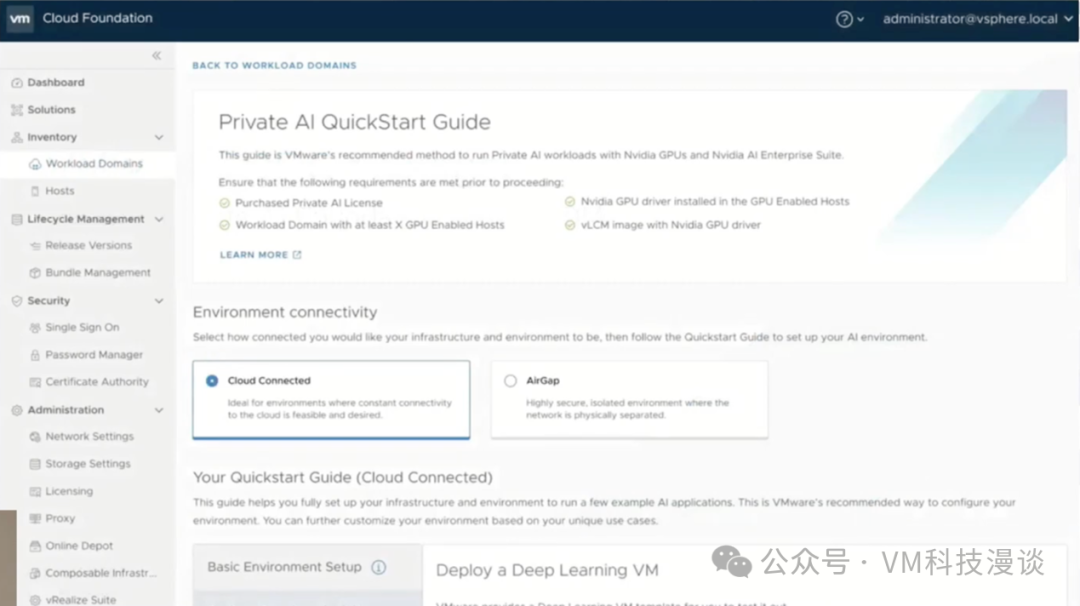

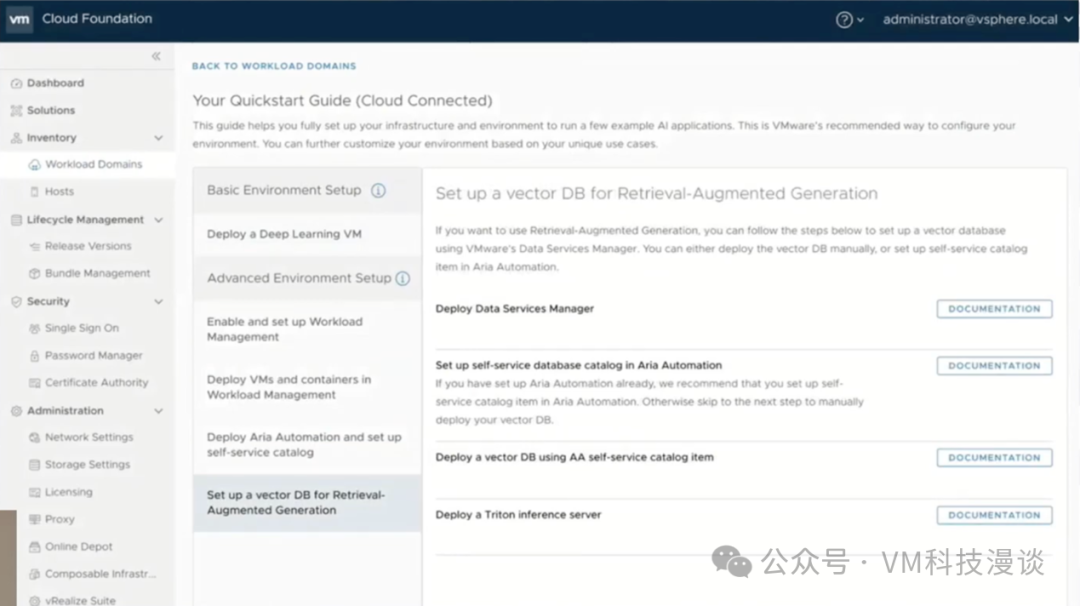

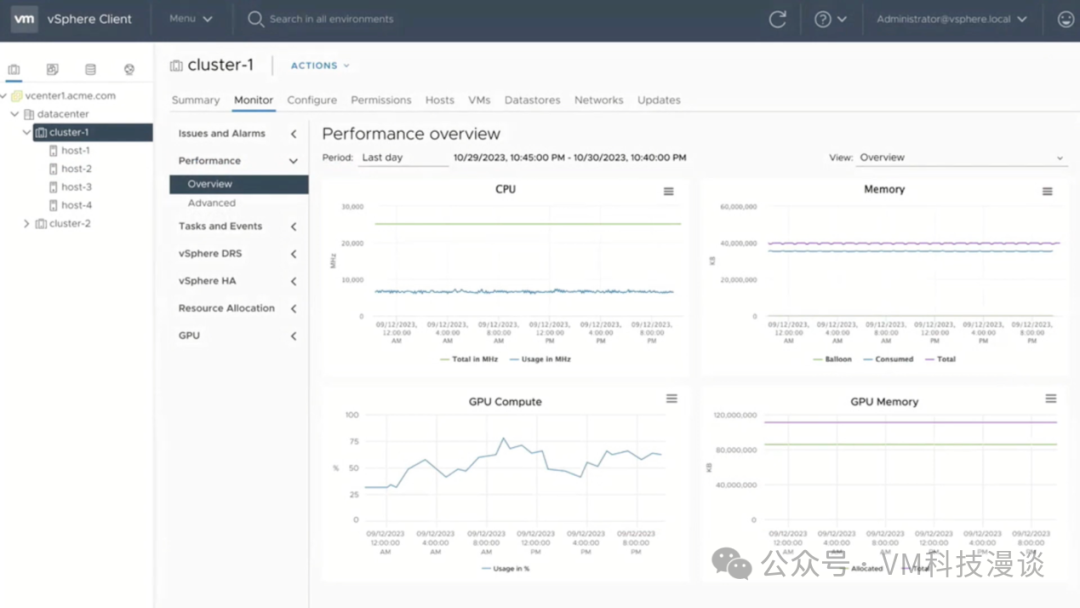

现在的目标是为数据科学家提供一个友好的用户界面,这也是该解决方案的主要受众之一。我们有两个目标用户群体,一个是数据科学家本身,另一个是为数据科学家提供服务的人员,也就是运营这个平台的团队。方案在设计中也考虑到了这两方面的需求。自助服务目录既支持图形用户界面(GUI),也提供API接口访问,并且可以利用API进行集成,比如DevOps人员可以使用API来驱动和启动一个我们称为云消费界面(CCI,Cloud Consumption Interface)的K8s集群。 数据科学家希望操作过程尽可能简单,他们会根据自己的需求做出选择,比如他们可能希望只需要一个简单的虚拟机来工作,或者他们可能需要一个完整的K8s集群来支持他们的工作。 在这些基础设施背后,提供了一组深度学习虚拟机,这些虚拟机以OVA格式来分发。OVA是开放虚拟化架构(Open Virtualization Architecture)的缩写,它是一种用于分发虚拟机的标准打包机制。因此,作为与NVIDIA合作的Private AI Foundation的一部分,用户将会收到我们提供的一组虚拟机。 这些虚拟机内预装了各类数据科学相关的工具包,包括广受欢迎的TensorFlow和PyTorch,对于数据科学家来说,Jupyter Notebook已成为进行数据科学工作的标配,特别是结合了Python的Jupyter Notebook。可以选择使用Conda或Docker引擎进行虚拟化,只需运行单个容器,或者通过K8s来管理多个容器。 值得一提的是,VMware提供了一些预制的、经过优化的深度学习虚拟机,让用户可以轻松地创建并快速投入使用。这些虚拟机会从VMware的全局目录中进行推送,会持续进行维护、更新及补丁修复,并将它们保留在存储仓库中供用户获取。 下面再来看看向量数据库,它是检索增强生成(RAG)技术的核心组成部分。检索功能由数据库部分实现,而增强则依赖于模型部分。它们协同工作,以更好地回答用户的问题。RAG在处理相关问题时非常有效,做为一种微调技术,它有多种实现方式,如P-Tuning(Prompt Tuning),即向模型应用额外的数据。向量数据库和RAG所展现出来的优势,以及我们从不同信息来源听到的反馈,都使它们成为进行LLM工作的最佳入门方式。 在实际操作中,用户通过一个客户端应用,如聊天机器人,输入问题。这个问题被转化为一个提示,但这个提示并不直接传输到数据库或其它地方。提示是一个句子,会被分解成单词,这个过程称为标记化。这些标记随后被转换成数值,即嵌入式数值。所有这些工作都由右侧的嵌入式模型完成,它理解用户的问题并将其转换成数值,这些数值随后被传输到向量数据库。 用户的私人文件及数据也可以加载到向量数据库,这将涉及嵌入式模型,这些私人文件及数据可能是用英语或HTML编写的,它们将提前加载到数据库中。所以,当用户发送查询请求到数据库,要求提供关于尚未发货的vSphere 8 Update 3的所有信息时,这些就会来自于私人数据。向量数据库能够进行相似性搜索,它会判断用户对vSphere 8 Update 3的兴趣,并检查数据中是否有索引到该主题的文件。当然,内部数据已经提前加载到数据库中,所以它会将相关文档返回给客户端应用程序。客户端应用程序会将这些文档发送给大语言模型进行汇总,然后数据库的结果被发送到大语言模型中处理,并呈现一个简洁的总结。 假设你坐在客户联络中心,有客户打电话来询问:“vSphere 8 Update 3有哪些特性?”而你旁边的同事对此一无所知。此时,你打开你的LLM问:“vSphere 8 Update 3有哪些特性?”(实际上vSphere 8 Update 3是几个月后的一个版本)。模型会回应:“这里是特性列表。”这一功能对于客户联络中心来说非常关键,因为它能帮助解决客户在网上或现有模型中找不到答案的问题。 对于大型企业采用LLM来说,这是一个非常关键的过程。以金融服务公司为例,假设该公司拥有一个LLM,并且顾问团队需要与客户会面,利用这一模型,公司可以为每个客户创建独特的数据库或RAG实例、向量数据库,并根据每个客户的特定需求调整模型。因此,当客户提出:“如果我们按照历史流程,即按照X、Y和Z去做,我的税收负担会是多少?”这样的问题时,公司能够以非常私密和个性化的方式为他们提供答案,甚至可能仅在一台笔记本电脑上完成,这主要取决于模型和参数的大小。想象一下,一个财务顾问使用他们金融机构提供的私人报告,这些非公开报告加载到数据库中,可以为客户提供针对性的解答,这是一个很有前景的想法。 接下来将会演示一个开源的向量数据库。而在向量数据库领域,VMware有一个特定的产品,恰好为用户提供了一个完美的方案,那就是PGVector。 需要强调的是,如果这种技术基于数据库,并结合加密和基于角色的访问控制,那将更为理想。因为处理的是私人数据,如私人银行报告,这些数据在外部世界中是不可见的。 VMware正与PostgreSQL合作,这是一个已具备加密和基于角色的访问控制功能的数据库。这样,用户可以确信数据的安全性。VMware在其基础上增加了一层,将PGVector作为一个容器,你可以通过Docker或K8s启动它,它连接到PostgreSQL并提供向量接口。这个向量接口用于相似性搜索。 例如,当用户搜索“vSphere 8 Update 3”时,它会为你展示与之相似的文档。用户可以使用VMware Cloud Foundation中的数据服务管理器工具进行配置。这里有一个已经配置好的PostgreSQL数据库,该数据库已准备好与PGVector容器连接,并计划用作向量数据库。值得一提的是,这个工具不仅限于为PostgreSQL提供配置,而是适用于多种不同的数据库。 在推进过程中,面临的一个问题是关于私人数据与公开数据之间的转换。例如,如果计划进行一项推广活动,用户可能需要在私人数据上进行处理,直到数据可以公开为止。届时,用户只需简单地输入查询语句,如“显示所有即将在星期三推出的文档”,系统便会自动展示相关结果,无需额外操作,这将极大地方便用户的工作。这是完全可行的。从右边的大语言模型来看,之所以引入向量数据库,是因为该模型是在两三个月前训练的,因此并未涵盖最新的私人数据。现在,可以在后台重新训练该模型的一个新版本,并使用即将公开的数据进行训练。在推广活动的前一天,将新模型投入生产并进行必要的测试。这样,就无需依赖RAG数据库,因为模型已经更新至最新状态。 然而,值得注意的是,模型会随时间而逐渐过时。这种方法的优势在于,一方面,数据和向量数据库的内容始终保持最新;另一方面,模型始终保持活跃,持续处理并反馈给出的词汇,同时确保数据的私密性。 当前,全球已有超过60家客户在使用这项技术,尽管它尚未正式发布。这确实是一个相当大的市场。它涵盖了各个行业,最常见的应用场景是通过带有聊天接口的RAG处理私人数据。这对我们开始的对话非常有帮助。 VMware SDDC Manager VMware将提供一系列指导建议,其中包括VMware Cloud Foundation中的SDDC Manager。SDDC管理器是一个令人敬畏的工具,因为它涉及到数百甚至数千台服务器。许多大型企业使用它来划分其VMware环境,例如市场营销工作负载域、商业智能工作负载域等。这也是VMware在与用户交流时经常关注的一个点。 VMware将提供部署指南、用户手册和快速入门指南,以指导如何执行前面提到的所有步骤,例如部署深度学习虚拟机、搭建向量数据库等。同时,工具本身也会提供具体的操作指南。 GPU监控 最后一个话题——GPU监控。VMware已经满足了数据科学家的需求,为他们提供了所需的工具和平台。他们建立了模型,并正在使用这些模型进行推理。 这里想要展示的是,在性能优先级列表中,除了CPU消耗和内存消耗外,现在还包括GPU计算消耗和GPU内存消耗。因为这些设备成本高昂,特别是高端的H100设备。我们希望确保这些设备得到充分利用。 在此之前,先简要介绍一下NVIDIA的一些组件。GPU Operator已经存在好几年了,这个工具非常出色。因为在使用NVIDIA栈时,用户需要管理两个驱动程序:一个驱动程序用于ESXi,另一个驱动程序用于运行GPU的每个虚拟机。但在K8s环境中,GPU Operator会接管这些驱动程序的管理,它会负责安装客户驱动程序,管理其健康状况,并在K8s的Pod中运行,只需告诉它这是用户需要的K8s集群,以及需要的GPU,然后它会处理剩下的事情,这极大地简化了用户的管理工作。这样,用户就不需要再将驱动程序安装到客户操作系统中了。 推理时间是所有训练时间的回报,是投资,是发展,且推理时间往往是生产,我们希望生产是可扩展的,而NVIDIA的Triton推理服务器正是为此而设计的。例如,当跨两个GPU部署了它,并在每个GPU上放置了一个Triton推理服务器。它是模型驱动的,这一点非常重要,因为我希望有一个包含不同版本、不同数据集的模型库,而不仅仅是一个模型。在组织中,可能会有数十甚至数百个模型,用户需要对这些模型进行控制。MLOps供应商会处理这些需求,但他们需要一个存储库。NVIDIA在这里创建了一个高度可扩展的推理服务器,它拥有API接口,用户可以通过API或客户端应用程序访问他们的模型。客户端应用程序位于右侧,它们插入查询、提出问题,适当的推理服务器会接收并处理这些问题,并代表用户去执行模型。 最后,关于如何采取限制措施,实际上,NVIDIA提供了一系列的技术手段来帮助实施这些措施,这些技术可以有效地预防偏见,并在很大程度上解决偏见问题。此外,它们还能够检测并排除拒绝服务攻击,确保模型的安全无虞。NVIDIA提供了一系列最佳实践和技术支持,为用户的模型提供全方位的保护。 VMware AI解决方案相关信息链接 Artificial Intelligence Solutions | VMware AI: https://www.vmware.com/artificial-intelligence.html VMware's Approach to Private AI: https://news.vmware.com/technologies/vmware-technology-private-ai Deploying Enterprise-Ready Generative AI on VMware Private AI: https://core.vmware.com/resource/deploying-enterprise-ready-generative-ai-vmware-vmware-cloud-foundation |

原创栏目

企业视频

IT百科

网友评论

聚超值•精选

-

- 撼讯 (PowerColor) RX6650XT 竞技 AMD台式游戏显卡电竞独显RX6600 8G显存 【RX6600 竞技】

- 券后省100

-

¥1499.0

¥1599.0

- 阿米洛(Varmilo) 熊猫系列机械键盘 静电容V2轴体 键盘机械 游戏键盘 程序员键盘 熊猫MA87键白灯 静电容V2雏菊黄轴

- 券后省50

-

¥869.0

¥919.0

- 闪迪(SanDisk) 256GB USB3.2 U盘CZ74提速升级400MB/s全金属高品质u盘安全加密学习办公商务优盘大容量

- 券后省10

-

¥149.0

¥159.0

- Apple/苹果 Watch Ultra2 智能手表GPS+蜂窝款49毫米钛金属表壳蓝色高山回环式表带小号MRFA3CH/A

- 券后省400

-

¥6099.0

¥6499.0

- vivo iQOO Z8 12GB+512GB 曜夜黑 天玑 8200 120W超快闪充 5000mAh超长续航 5G手机

- 满1000减150

-

¥1989.0

¥1999.0

-

- 玩嘉玩嘉孤勇者PLUS黑色全景版海景房机箱(钢化玻璃侧板免螺丝/防尘网/360水冷/ATX主板/40系显卡

-

¥219.0

¥299.0

- 优派(ViewSonic) 29英寸电脑显示器 21:9超宽带鱼屏 IPS广视角面板 HDR技术 75Hz 微边框 低蓝光不闪屏 节能 商务办公优选 VA2962-HD

- 券后省200

-

¥949.0

¥1149.0

- BoseQuietComfort 真无线蓝牙降噪耳机 大鲨系列大鲨3代 智能耳内音场调校 刘宪华代言 新年礼物 消噪耳塞II-白色 国行官旗店 全国联保

- 券后省200

-

¥1299.0

¥1499.0

- Apple/苹果 Watch Series 9 智能手表GPS款45毫米粉色铝金属表壳 亮粉色回环式运动表带 MR9J3CH/A

- 券后省400

-

¥2749.0

¥3149.0

- 漫步者(EDIFIER) W820NB双金标 Hi-Res主动降噪耳机 头戴蓝式牙耳机适用苹果安卓 【双金标版】典雅灰+赠耳机包

- 券后省30

-

¥369.0

¥399.0

-

- 漫步者小奶豆蓝牙耳机无线半入耳式新款X1适用华为苹果小米等2024

- 券后省17

-

¥89.0

¥129.0

- 哈曼卡顿(Harman/Kardon)琉璃3代 蓝牙音箱 音乐琉璃三代台式家用桌面电脑音响 低音炮 Aura Studio3代 白色

- 券后省30

-

¥1389.0

¥1419.0

- 三星(SAMSUNG)Galaxy Buds2 Pro 智能主动降噪真无线蓝牙耳机/24bit高保真音频/IPX7防水/佩戴舒适 哥特太空

- 券后省10

-

¥989.0

¥999.0

- Apple/苹果2023款Mac mini迷你主机【教育优惠】M2 Pro(10+16核)16G 512G 台式电脑主机MNH73CH/A

- 券后省300

-

¥8899.0

¥9199.0

- 机伯楽苹果MagSafe磁吸TPU保护壳iPhone仿液态硅胶CD纹直边手机壳自带镜头膜 【暗夜紫】CD纹磁吸壳 iPhone 14

- 券后省77

-

¥129.0

¥206.0

-

- 京东云无线宝路由器 AX3000哪吒 【下单全额返】WiFi6 5G双频 全屋Mesh组网 3000M无线速率 千兆家用路由器

- 券后省6

-

¥222.0

¥228.0

- 品胜 适用苹果15手机壳 iPhone15保护套简约透明气囊防摔超薄防震耐磨防尘全包抗指纹网红软壳 透明

- 券后省4

-

¥25.0

¥29.0

- 索泰 ZOTAC ZBOX迷你mini主机EN072060C台式机2060图形显卡工作站设计师渲染边缘计算设备 准系统【不含内存硬盘】

- 券后省100

-

¥2999.0

¥3099.0

- IDMIX 充电宝自带线苹果MFi认证PD20W快充1万毫安时适用苹果14/13/12Pro/Max PD20W快充自带苹果MFI认证线/绿色

- 券后省40

-

¥259.0

¥299.0

- 小米平板6 MAX 14英寸 高通骁龙8+ PC级WPS 2.8K 120Hz 8+256GB办公平板电脑 银色【键盘+触控笔套装】

- 券后省100

-

¥4697.0

¥4797.0

安浦(编译)

安浦(编译)

硬件编年史

硬件编年史