太平洋科技 企业站

VMware Private AI方案详述六:VMware 内部Private AI实践分享

安浦(编译)

整合编辑:王珂玥

发布于:2024-05-06 10:18

安浦(编译)

整合编辑:王珂玥

发布于:2024-05-06 10:18

|

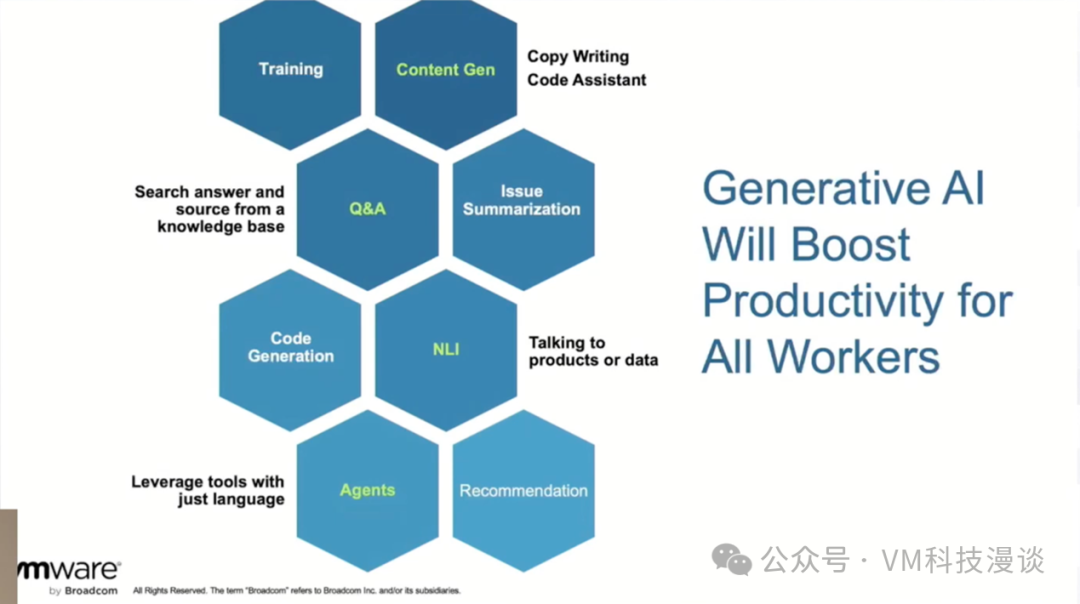

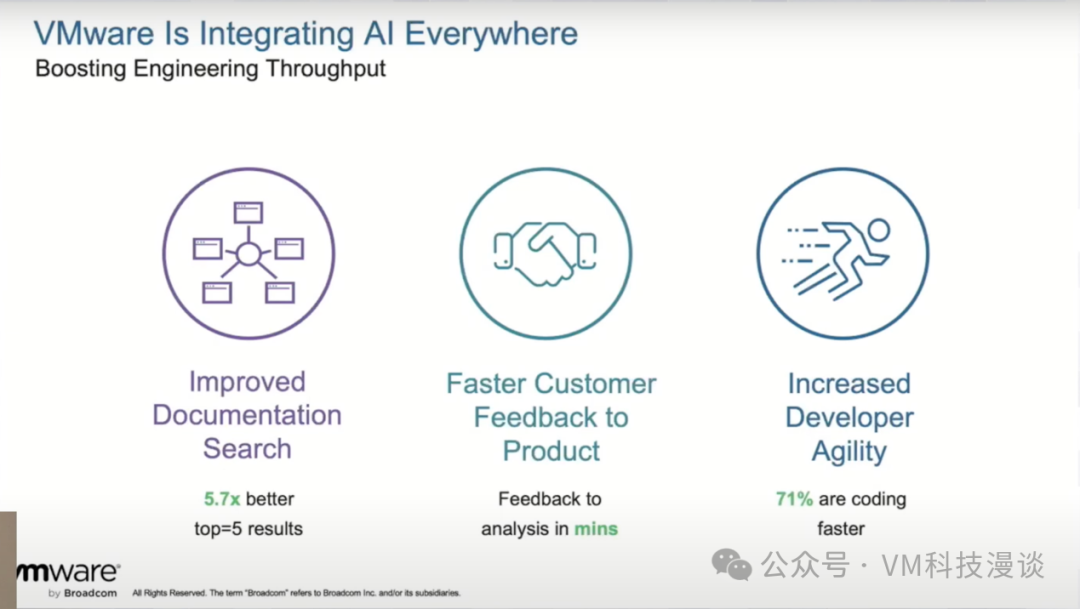

本文编者为VMware中国资深架构师安浦,基于2024年2月21日VMware by Broadcom 在 Tech Field Day 活动现场AI Field Day 4主题的系列演讲整理。演讲嘉宾为Ramesh Radhakrishnan,AI Platform & Solutions, VMware By Broadcom。 内容摘要 -VMware内部AI服务,包括编码辅助服务,使用检索增强生成(RAG)进行文档搜索的服务,以及内部的LLM API等。 -VMware内部LLM的关键用例,包括内容生成、问题回答、代码生成和AI代理的使用等。 -VMware的智能云策略,利用公有云训练开源 LLM,以减少 GPU 运行对环境的影响。 -与斯坦福大学合作,为内部文档搜索创建了一个领域自适应模型,与传统的关键字搜索相比,显著提高了搜索性能。 -VMware自动问答系统(vAQA)是一个基于语言模型的信息检索系统,它允许用户在不浏览文档的情况下提出问题并得到相关答案。该系统的实现涉及复杂的过程,包括内容收集、预处理、索引、缓存和更新文档。 -VMware扩大了GPU能力,VMware的AI平台提供GPU池资源、开发者环境、编码用例和LLM API,这些都运行在一个公共平台上。 -数据管理是人工智能用例的潜在瓶颈,平台标准化对于高效地为终端用户提供服务至关重要。AI团队和基础架构团队之间的协作对于确保模型和基础架构能够有效支持工作负载至关重要。 -组织可从小型开源模型开始,逐步扩大规模,确定关键绩效指标(KPI),并专注于用AI解决业务问题。强调实施人工智能的战略方法的重要性,以及利用人工智能服务共享平台的好处。 演讲正文 本演讲将会介绍VMware内部Private AI的一些实践情况。在大语言模型尚未出现之时,VMware内部就已经着手准备了一系列的应用场景。随着大语言模型的快速发展,VMware也将其引入进来,并为其它团队打造了基于此的平台功能,使他们也能够构建这些应用场景。在这方面,VMware总结了一些重要的心得体会,方便其它客户或与VMware处于相似发展阶段的组织能够从中汲取经验。 当探讨各种应用场景时,大语言模型就像一把锤子,而各种应用场景就像是钉子。这是因为大语言模型能够在几乎不修改的情况下应对各种应用场景,这正是其魅力所在。 VMware内部AI应用场景及相关服务 其中一个核心应用场景是内容生成。大语言模型不仅被训练用于文本生成,还具备多模态能力,如图像和视频生成。很多人都可能注意到了最近发布的Sora,在这个信息爆炸的时代,当人们谈论问答时,大家都希望能够更高效地搜索。大语言模型不仅可以从不同来源获取答案,还能综合这些来源,为人们提供答案,无需阅读多个文档。 关于代码生成,需要再次强调,这不仅仅适用于传统程序员,还包括使用如Terraform等工具的管理员。这一领域的应用场景非常广泛。 最后,还会看到许多代理出现在演示中。这些代理将利用多个应用场景,并将它们相互连接,或者通过整合所有应用场景,构建出复杂的解决方案,以实现更有价值的目标。这个领域的发展前景非常广阔,未来将继续壮大。 包括VMware在内的所有组织都希望利用生成式AI的潜力,但我们必须谨慎处理这些应用场景和团队需求。在此,需要再次强调,VMware公司内部制定了一套关于如何使用这些生成式AI能力的政策,为团队提供了明确的指导方针。 VMware的智能云策略 VMware采取的一种策略是采用智能云的方法。过去,VMware已经探讨过智能云在传统应用中的应用,但当涉及到AI应用时,这意味着将会利用在公有云上训练的这些大语言模型。这些模型现在是开源的,并配备了商业许可,使人们能够在自己的应用场景中运用它们。通过这种做法,可以避免在不需要时运行GPU,从而节省大量的碳排放并减少对环境的影响。 一旦这些大语言模型融入我们的基础设施,就能够灵活地应用于多个场景,并根据需要调整模型的性能和延迟。这让我们能够以非常可持续的方式进行操作。实际上,对于许多应用场景,我们并不需要700亿或1000亿参数的模型。一些经过微调或专门设计的较小模型就能胜任。 在推进这一策略时,我们优先考虑的是来自内部团队的实际需求。第一个应用场景是改进文档搜索。据一项调查显示,大家约有40%的时间都花在寻找信息上。无论是程序员在Stack Overflow上搜索,还是产品经理在Google上寻找内容,都面临着同样的问题。因此,我们与斯坦福大学合作,为VMware量身定制了一个领域自适应模型,该模型在前五个检索结果中的性能比传统搜索提高了约五倍半。这是与关键词搜索相比的提升。然后,我们将这个模型适配到VMware的词汇表,以获得更优于现有技术的结果。 为了确保产品与不同版本的文档进行交互,比如过去可能有类似的短语,从vSphere 6/7中提取的匹配项可能与实际需要的8.0版本不匹配,为此使用了神经搜索技术,它具有上下文理解能力,所以它能够识别你所使用的版本,并据此提取相关文档。如果没有明确指定版本,系统会默认提取最新的信息。但如果我们有关于使用版本的上下文信息,系统就会根据这些信息去收集资料,从而导向正确的文档。 我们并不是在改进文档本身,而是利用现有的文档。另外,除了索引文档之外,我们还会从Confluence页面和外部博客中提取信息。因此,我们的所有内容都会被索引并用于搜索。所以,当用户提问时,我们的系统会查找相关的段落或信息,并提取出来,无论是从文档还是其它外部来源。这些文档、博客文章、内部KBS以及所有其它来源都在不断地更新。 最后,关于开发者的灵活性。根据我们的调查,许多程序员都希望有一个编码助手。因此,我们希望能够为他们提供一个内部运行的服务,这样我们的代码就都能保留在我们自己的防火墙内了。 VMware自动问答系统(vAQA) 下面来深入探讨一下文档搜索。我们的系统被称为VMware自动问答系统(vAQA),它不仅仅是一个简单的搜索工具。你可以直接提问,系统会为你提供相关答案。因此,你无需再费心浏览大量文档来寻找所需信息。正如之前提到的,文档数量庞大且总是不断增加。 我们所做的是构建了一个基于语言模型的信息检索系统。虽然现在的大语言模型可以完成这项工作,但要确保获得准确的答案、提供有效的防护措施并正确处理上下文,仍需要大量的工程工作。大约在两年半前,我们开始与斯坦福大学合作,当时使用的是最先进的语言模型ColBERT。随着时间的推移,我们对问答系统进行了多次改进。 基本上,这个过程可以分为四个步骤。当收到查询请求时,系统会首先清理查询。然后,所有被索引并存储在数据库中的数据都会被传递给ColBERT模型。模型会从数据库中提取相关文档,并将其传递给问题回答系统。该系统会突出显示相关段落,并将结果返回给用户。听起来很简单,对吧?但实际上,为了确保超越最先进的结果,我们进行了大量的实验和微调。 当我们准备将系统投入生产时,事情变得更加复杂。刚刚展示的是右侧的部分,包括信息检索、预处理程序和问题回答系统。左侧的部分,包括文档更新、索引处理以及当文档发生变化时的处理流程。 整个流程始于内容收集。你可以使用内容编制系统,如DocWorks,将内容直接推送到语料库。但我们还希望使用其它许多文档。因此,我们需要使用爬虫服务从网站上抓取信息,并将其更新到数据库中。这并非易事,因为每个网站的结构和内容都有所不同,这使得整个过程变得相当复杂。 一旦获取了这些信息,它们就会被发送到内容管理服务。服务会全面检查我们手中的所有信息,并进行预处理,如将内容转换为markdown、删除无用信息等步骤,都会一一处理。此外,为了应对拼写错误和复杂词汇,还设有专门的预处理程序。我们还需要进行标记化处理,以便处理词汇表之外的单词。当所有这些清理和准备工作都完成后,信息就会被送到索引管理环节。 在索引管理中,我们会基于收集的所有数据创建新的索引,这属于日常操作。简单来说,我们会爬取所有信息和文档,查找更新内容,然后据此更新索引和文档。 为了提高效率,我们还对缓存进行了优化。如果之前已经进行过某个搜索,并且缓存中有相关信息,那么系统就无需再次进行搜索,从而提高了处理速度。 在索引过程中,我们也利用GPU进行计算。这种按需启动的方式,可以在不需要时节省GPU资源。 我们已经将这项技术应用于RAG应用场景,从而构建了一个对话引擎。该引擎使用了大语言模型,并通过技术优化来增加上下文容量。在此场景下,我们没有使用向量数据库,而是直接调用API来获取所需信息,并据此回答问题。 当前许多组织都在努力解决爬取、更新索引、数据库基础架构等挑战。我们提供了一些基础服务,也已经掌握了相关的技术,目前正在研究如何将其包装成更通用的服务,以便更多的客户能够使用,并集成到他们的Private AI系统中。同时,我们也与我们的专业服务团队合作,根据客户的特定需求,提供定制化的服务。 关于应用场景,我们讨论了在内部为员工构建的问答助手。接下来会介绍一下这个工具本身。 VMware扩大了GPU能力 在初期,我们的主要受众和客户是数据科学家,他们是利用机器学习模型解决实际问题的人。他们当时需要一些GPU资源,但大部分工作实际上是在CPU上完成的。因此,我们构建了这个平台,允许用户按需请求算力资源。我们为他们提供了所需的开发环境,无论是Jupyter Notebook还是Visual Studio,他们都可以开始构建和测试模型。 然后ChatGPT的出现彻底改变了情况。现在,我们有大量的软件开发人员需要构建应用程序,他们对GPU的需求也显著增加。但即便如此,我们仍然使用同一个平台来处理这两种不同类型的应用场景。 对于许多软件开发人员来说,他们实际上不需要直接访问计算环境或开发环境,他们只需要API接口。因此,我们构建了一个托管服务,部署了许多大语言模型,并提供API接口供他们使用。我们持续迭代平台,添加新功能。同时,我们也在预测,随着新模型的推出,我们的客户群体会有新的需求。 这就是我们的平台概貌。我们建立了一个GPU资源池,确保任何用户都不会独占资源。一旦用户完成任务,资源就会释放回池中。我们在平台上部署了开发环境、编码应用场景和大型语言模型API。 数据管理的重要性及企业AI实践的最佳策略 数据是一个关键因素。在很多AI应用场景中,数据都是瓶颈。虽然时间原因,我们没有深入探讨这一点,但它确实是值得注意的地方。使用通用的模型和标准化的平台可以帮助组织更好地向最终用户提供服务。这样,不同的团队就不会重复解决同样的问题。对于AI团队和基础架构团队来说,协同工作至关重要。即使你有最好的模型,但如果没有合适的基础设施或无法扩展基础设施来处理工作负载,那么这些模型将无法得到充分利用。同样,如果你拥有出色的基础设施,但没有优秀的AI模型或服务,那么也无法实现最佳效果。因此,建议从一些开源模型开始,明确你的KPI和需要解决的业务问题。这是组织开始时的最佳策略。这就是我们的做法。

Artificial Intelligence Solutions | VMware AI: https://www.vmware.com/artificial-intelligence.html VMware's Approach to Private AI: https://news.vmware.com/technologies/vmware-technology-private-ai Deploying Enterprise-Ready Generative AI on VMware Private AI: https://core.vmware.com/resource/deploying-enterprise-ready-generative-ai-vmware-vmware-cloud-foundation |

原创栏目

企业视频

IT百科

网友评论

聚超值•精选

-

- 机械革命无界14X 2024新品 AIPC智能旗舰锐龙7 8845HS轻薄本 14英寸高性能设计师办公学生游戏笔记本电脑 120Hz高刷 2.8K高色域 金属灰 R7-8845HS 24G内存1TB固

- 券后省300

-

¥5399.0

¥5699.0

- 领普人体存在传感器 米家智能联动 毫米波雷达感应人在灯不灭 人体存在传感器-侧装版

- 券后省2

-

¥137.0

¥139.0

- 西部数据(WD)1TB SSD固态硬盘 M.2接口 SN770 PCIe4.0 2280(NVMe协议)AI电脑配件 笔记本电脑游戏硬盘

- 券后省30

-

¥639.0

¥669.0

- 【顺丰】锐捷星耀WiFi6黑豹电竞路由器X30E PRO千兆家用无线AX3000双频5G 游戏大户型全屋WiFi覆盖官方旗舰店

- 券后省10

-

¥289.0

¥299.0

- 京东云无线宝 AX3000后羿权益版路由器 每月领会员 全屋Mesh组网 3000M无线速率 越级穿墙体验

- 每满349减100

-

¥343.0

¥349.0

-

- 卡尔wifi6无线千兆家用光纤高速路由器 mesh组网穿墙王全屋增强器

- 券后省100

-

¥109.0

¥209.0

- 狸贝多 苹果天使眼肤感保护壳防摔仿液态手感TPU直边手机壳 柠檬黄【天使眼】保护壳 iPhone 13

- 券后省10

-

¥17.0

¥27.0

- CHINOE-中诺2W毫安大容量充电宝22.5W双向快充移动电源

- 券后省100

-

¥69.0

¥169.0

- 索泰(ZOTAC) RTX4070 X-GAMIN天启 4070 SUPER显卡/N卡/台式机/电脑独立显卡 RTX4070 SUPER 12G 天启OC

- 券后省200

-

¥5799.0

¥5999.0

- 漫步者(EDIFIER) M30 蓝牙5.3音箱 游戏音箱 笔记本电脑桌面家用台式机音响 内置麦克风 黑色

- 券后省16

-

¥173.0

¥189.0

-

- 雷克沙(Lexar)128GB SD存储卡 U3 V60 4K数码相机内存卡 读250MB/s 写120MB/s 双排金手指(1667x Pro)

- 券后省10

-

¥269.0

¥279.0

- 西部数据(WD) 2TB 移动固态硬盘(PSSD)Elements SE新元素 SSD type-c接口 手机直连笔记本电脑外接

- 券后省20

-

¥949.0

¥969.0

- 联想(Lenovo)小新一体台式机电脑23.8英寸(R5 5500U 8G 512G SSD 摄像头 win11 )白

- 券后省10

-

¥3089.0

¥3099.0

- B&O Beosound A9 5.G 5代一体式无线WiFi蓝牙家用音箱音响 触控调音 音箱 A9 4G 白色

- 券后省250

-

¥18949.0

¥19199.0

- ikbc Z87大魔高达大魔联名键盘无线键盘机械键盘无线游戏办公键盘87键红轴

- 券后省20

-

¥219.0

¥239.0

-

- 八位堂猎户座真无线游戏手柄ALPS摇杆Switch苹果PC电脑Steam安卓 原神 我的世界 狂野飙车9 幻兽帕鲁

- 券后省3

-

¥186.0

¥189.0

- FIIL Key 真无线蓝牙耳机 通用手机耳机 音乐耳机 蓝牙5.3 曜石黑

- 券后省10

-

¥139.0

¥149.0

- 腹灵CMK99蓝牙/2.4G/无线三模客制化机械键盘游戏办公热插拔RGB灯光TTC快银虎轴 三模FSA球帽版-全键可换轴-冰川蓝 TTC-金粉轴V2

- 券后省20

-

¥799.0

¥819.0

- 惠威(HiVi) M10 Plus 2.1声道电脑音箱 笔记本台式家用客厅电视蓝牙音响 有源多媒体

- 券后省25

-

¥634.0

¥659.0

- 英睿达(crucial)MX500笔记本台式电脑ssd固态硬盘sata3.0接口高速读写 480G-500G 读取速度高达560MB/s MX500系列/SATA3.0/3D进阶高速

- 券后省15

-

¥334.0

¥349.0

安浦(编译)

安浦(编译)

硬件编年史

硬件编年史