太平洋科技 企业站

AI的发展会让QLC走向C位么?

Asgardia

编辑: 王珂玥

发布于:2023-05-29 19:39

PConline原创

Asgardia

编辑: 王珂玥

发布于:2023-05-29 19:39

PConline原创

|

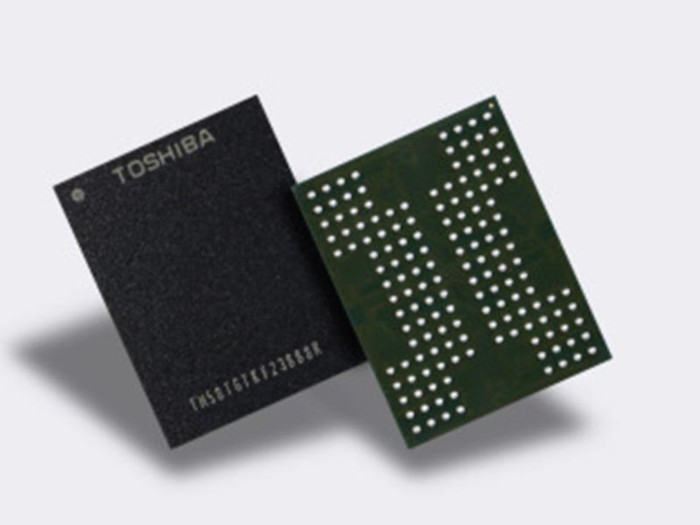

如今,企业对于GAI的需求迫切正在推动数据中心发生根本型的转变,更大的带宽、更低了延迟、更高的存储容量等等都在推动者新型基础设施的升级。一向被TLC碾压的QLC会走出经济与成本的发展樊篱,成为被更广泛接受的可能么? 我们看到生成式人工智能——以OpenAI的chatGPT为代表,这些技术在最近几个月正被美国和中国疯狂追追逐——以及它们背后的大语言模型(LLM)需要需要更多高性能的计算和存储预期匹配。当英伟达拿出DGX GH200这种用了NVLink、NVLink Switch等技术连接了256块的Grace Hooper超级芯片来支持超算的时候,以人工智能为重点的计算架构突破正需要更多的存储能力来匹配它们。 刚刚在德国举行的ISC23超级计算展(ISC23 supercomputing show)似乎说明了这个问题,HPC对AI和机器学习工作负载的高性能和经济选择的支持正显著强于对容器、云、分析工作负载这些传统工作。尤其是很多传统上那些在传统业务上的存储节点之间运行协调的IOPS,并非非常适合人工智能领域的继续应用。 更快速的访问与传输需求让NVLink、Fabric、NMMe等需要QLC成为高速存储网络的关键一环,成为成本效益的一个解决方案。尤其是,当QLC产品依旧使用NFS作为协议,并基于NFS来创新奇复发的备份策略的时候,这难免让QLC在TLC前依旧捉襟见肘,也并非是大模型的最佳选择。为此,QLC从边缘向存储中心的C位,也是AI创新的一个迫切需求。 企业们正在面临一道关键的选择题,为了获得最佳性能,他们依旧会钟情于TLC;但为了平衡应用大模型下的性价比,QLC的扩展会成为一个很好的选择。 |

原创栏目

企业视频

IT百科

网友评论

聚超值•精选

-

- 联想笔记本电脑小新Pro14轻薄本 英特尔Evo 14英寸超能本(14核标压i9 16G 512G 2.8K高刷屏)银 商务办公学生

- 券后省10

-

¥6489.0

¥6499.0

- Apple/苹果 Watch Series 9 智能手表GPS款45毫米午夜色铝金属表壳 午夜色运动型表带M/L MR9A3CH/A

- 券后省400

-

¥2799.0

¥3199.0

- Wacom数位板CTL-472手绘板Bamboo电脑绘画板PS手写板网课绘图板

- 券后省51

-

¥279.0

¥389.0

- 腹灵CMK98 单模有线客制化机械键盘热插拔PBT键帽RGB灯光办公游戏键盘笔记本台式电脑键盘 单模有线-牛油果-BOX-V2白轴

- 券后省20

-

¥599.0

¥619.0

- Apple/苹果2023款Mac mini迷你主机【教育优惠】M2(8+10核)8G 512G 台式电脑主机MMFK3CH/A

- 券后省400

-

¥4799.0

¥5199.0

-

- 图马思特T248P赛车方向盘 模拟器模拟驾驶游戏 GT7赛车神力科莎尘埃拉力赛 支持PS4/PS5/PC【进阶版】

- 券后省10

-

¥1889.0

¥1899.0

- ANKER安克 安心充Ultra苹果充电器氮化镓快充PD30W兼容20W iPhone15/14/13proMax/iPadPro 单头装磐石黑

- 券后省25

-

¥69.6

¥94.6

- Apple/苹果2023款MacBookAir 15英寸 M2(8+10核)8G 256G深空灰轻薄笔记本电脑MQKP3CH/A

- 券后省1300

-

¥9199.0

¥10499.0

- 北通宙斯有线游戏手柄xbox蓝牙六轴体感switch电脑PC手机steam机械按键宏背键NS只狼幻兽帕鲁原神 白金

- 券后省10

-

¥479.0

¥489.0

- 图马思特图马思特 T248X赛车模拟驾驶游戏方向盘 极限竞速地平线5/FORZA7 支持XBOX/WIN10/PC【进阶版】

- 券后省10

-

¥1889.0

¥1899.0

-

- HELLO GANSSGANSS 3104T/3075T 客制化机械键盘高斯三模无线键盘蓝牙2.4G有线热插拔办公游戏键盘 3104T白色【RGB】三模版 全键热插拔 KTT风信子轴

- 券后省130

-

¥169.0

¥299.0

- EHOMEWEI便携式显示器17英寸2.5KQled屏幕笔记本电脑switch手机Ps5外接扩展副屏 17英寸 2.5K 笔触【RQ3】

- 券后省200

-

¥1699.0

¥1899.0

- 西部数据(WD) 1TB 移动固态硬盘(PSSD)Elements SE新元素 SSD type-c接口 手机笔记本外置外接

- 券后省10

-

¥569.0

¥579.0

- 中国联通 手机卡流量卡上网卡全国通用5G不限速大萌卡沃派宝卡王卡学生校园卡奶牛卡 惠艺卡29元每月200G通用流量+100分钟通话

- 券后省4

-

¥1.01

¥5.0

- 雷神G50S无线游戏手柄 有线蓝牙三模switch pro类xbox手柄 Steam电脑NS手柄 G50S 极夜

- 券后省15

-

¥184.0

¥199.0

-

- 漫步者(EDIFIER) W820NB双金标 Hi-Res主动降噪耳机 头戴蓝式牙耳机适用苹果安卓 【双金标版】典雅灰+耳机包

- 每满399减30

-

¥359.0

¥399.0

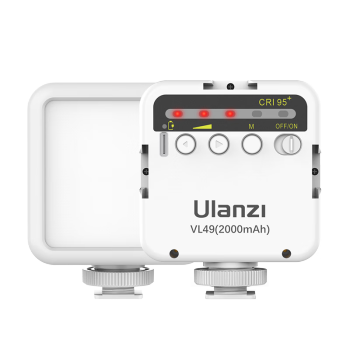

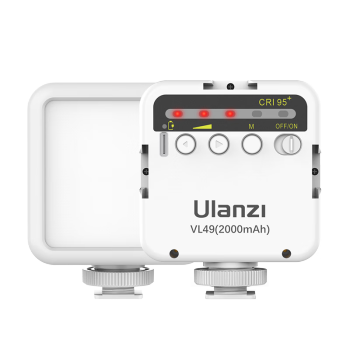

- ulanzi 优篮子 VL49(白)直播补光灯摄影led灯便携网红拍照柔光灯热靴主播美颜灯室内人像vlog手持打光灯

- 券后省5

-

¥64.0

¥69.0

- ThinkPad E14 英特尔酷睿i5 联想14英寸轻薄便携笔记本电脑(i5 16G 512G 100%sRGB 银)商务办公本

- 券后省10

-

¥4289.0

¥4299.0

- 荣耀Magic5 Pro 第二代骁龙8旗舰芯片 荣耀青海湖电池 5450mAh大电量 鹰眼相机 5G手机 8GB+256GB 勃朗蓝

- 券后省20

-

¥4879.0

¥4899.0

- Apple/苹果2023款MacBookAir【教育优惠】15英寸 M2(8+10核)8G256G星光轻薄笔记本电脑电脑MQKU3CH/A

- 券后省1300

-

¥8399.0

¥9699.0

推荐

手机

笔记本

影像

硬件

家居

商用

企业

出行

未来

Asgardia

Asgardia

硬件编年史

硬件编年史