太平洋科技 企业站

CPU在可持续AI/ML中的作用

佚名

整合编辑: 王珂玥

发布于:2024-02-04 18:09

佚名

整合编辑: 王珂玥

发布于:2024-02-04 18:09

|

随着人工智能在商业计算环境中的影响力不断扩大,它的影响正在引发一些意想不到的连锁反应。例如,IDC最新的FutureScape报告预测,随着公司竞相推出人工智能增强产品/服务,并帮助客户实施人工智能,这项技术将成为创新的关键动力。 另一个人工智能驱动的变化是,数据中心可能需要在多大程度上平衡CPU和独立的人工智能加速器(如GPU或专用架构),以提供人工智能开发人员想要的高性能计算能力。 对于数据中心所有者来说,这是一场高风险的争论,无论是在额外的资本支出投资方面,还是在典型的GPU驱动的人工智能操作(尽管测量方法不精确)比传统IT工作负载消耗更多电力的可能性方面。 处理人工智能更高的功率/碳开销是数据中心运营的另一个难点,它还必须确保为人工智能优化的升级计算架构能够管理增加的电力需求,而不会有现有技术或设施过载的风险。 因此,随着可持续性治理和碳管理方面的监管不断扩大,IT硬件和软件领域的运营都在减少能源消耗,人工智能既代表着机遇,也代表着障碍。 降低AI功耗 英特尔人工智能卓越中心(AI Center of Excellence)人工智能GTM总监StephanGillich解释说,总的来说,不断增加的功耗,以及适应人工智能和机器学习工作负载所需的必要架构重构,对数据中心构成了不可阻挡的挑战。 “很明显,在垂直行业和行业中,无论人工智能/机器学习应用程序和服务在哪里开发、培训和运行,本地和云托管It设施的功能都必须进行升级,以应对不断增加的数据密集型工作负载。”Gillich表示。“同样明显的是,这些升级不仅仅需要提高计算能力。” Gillich认为,从重新评估围绕人工智能/机器学习领域的一些假设开始,可以做很多事情来增强以人工智能为重点的数据中心的可持续性。处理单元是一个很好的起点,特别是在决定CPU还是GPU更适合任务时。 因为虽然人工智能特定的计算密集型工作负载似乎在增加(没有人确定以什么速度增加),但数据中心的大部分工作(非人工智能工作负载)必须继续日复一日地工作——提供稳定的应用程序和服务收入流,不受干扰。 目前,大多数数据中心都是由CPU处理的,用更昂贵的GPU来改装一个标准的数据中心,对于很多设施来说,是多余的。一般来说,GPU比CPU消耗更多的瓦数来执行类似的任务。根据给定机架配置的电源,将GPU集成到数据中心基础设施中需要升级配电系统,例如,这必然会产生额外的前期成本,以及运行后更高的能源费用。 此外,英特尔的CPU开发还在不断创新。Gillich认为,在多个用例中,CPU可以证明实现与GPU一样好的整体性能,有时甚至更好。它们的性能可以通过突破性的技术来增强,比如英特尔®AMX(高级矩阵扩展),这是一种内置在第四代英特尔至强CPU中的加速器。 “英特尔至强处理器可以通过内置的人工智能加速,提高CPU在机器学习、训练和推理方面的性能,从而使数据中心能够扩展人工智能的采用。”Gillich表示“通过这种方式,他们可以采用分立加速器,以最大限度地减少资本支出并最大化性能,同时利用现有的英特尔至强处理器环境。” 需要混合人工智能和非人工智能工作负载 英特尔AMX是英特尔至强可扩展处理器核心上的专用硬件块,它使人工智能工作负载能够在CPU上运行,而不是将它们卸载到独立的加速器上,从而显著提高了性能。它适用于机器学习推荐系统、图像识别和自然语言处理等依赖于矩阵数学的人工智能工作负载。 支持增强型CPU的另一个理由是,它们为数据中心运营商提供了一种经济有效的途径,使他们能够更多地利用现有的CPU,为他们的资产提供未来的保障,以便他们能够承担混合工作负载,并将它们置于更好地控制整体功耗的位置。 反过来,这可能会帮助数据中心服务提供商(及其客户)实现可持续发展目标,并为正在寻找优化平台以展示其编码输出的能源效率的软件开发人员(企业或第三方)提供卖点。 这些需求可能包括:人工智能工作负载与非人工智能工作负载的集成;不同硬件和软件栈的集成;因为他们想要确保他们的架构适合多种不同的工作负载,不同工作流类型的集成。 “这些问题指向了复杂的挑战,因为正确解决这些问题关系到最佳技术和能源效率——能源效率现在是一个核心性能基准,将越来越多地影响数据中心的商业可行性,”吉利奇说。“所以再说一次,这是最重要的。” 从Gillich的角度来看,适应这种新兴现实的关键是一个可以被称为“人工智能同化”的步骤过程。这里的第一点是,人工智能工作负载不会与其他工作负载类型隔离开来——它们将集成到传统工作负载中,而不是单独运行。 Gillich给出了视频会议作为这种分阶段集成的一个例子:“在跨标准应用程序传输标准音频/视频流量时,人工智能已经集成到执行伴随任务,如摘要、翻译、转录。人工智能很好地支持这些功能。 端到端节能 Gillich认为,实现能源效率必须是一项真正的端到端战略任务。“它跨越了软件端和硬件架构——实现给定工作流过程的完整机制。数据存储在哪里,以使访问效率最高——在计算方面,因此在能源方面——这是提高能源效率的最佳地点吗?” 在此评估中要考虑的另一个因素是确定工作负载运行的位置。例如,它是否运行在客户端(例如配备英特尔酷睿Ultra处理器的AI PC)上,而不是数据中心的服务器上?这些AI工作负载中的一些实际上可以在客户端(与服务器一起)上运行吗? 每一个选择都值得考虑,如果它将有助于使人工智能计算/功耗平衡更好地协调,吉利奇认为:“这几乎就像回到分布式计算的老派概念。” Gillich补充道:“有时候我们的客户会问,‘人工智能将在哪里发挥作用?——答案是,人工智能无处不在。因此,在英特尔,我们的目标是专注于所谓的人工智能的普遍适应,因为我们相信它将进入所有应用领域。” 在英特尔,这包括API等中间件,与软件堆栈的任何其他部分一样,它们必须尽可能高效。“API蔓延”可能导致不必要的处理,减少基础设施的占用,以及缺乏监控。 “通过英特尔oneAPI,企业可以实现其全部硬件价值,开发高性能的跨架构代码,并使其应用程序为未来的需求做好准备,”Gillich解释说。 “英特尔oneAPI是一个开放的、跨行业的、基于标准的、统一的、多架构的、多供应商的编程模型,它提供了一个跨加速器架构的通用开发人员体验,以实现更快的应用程序性能,并提高生产力。oneAPI倡议鼓励在整个生态系统中就oneAPI规范和兼容的oneAPI实现进行协作。” Gillich补充说:“oneAPI提供了一个中间件堆栈,它采用人工智能框架(如Pytorch或TensorFlow[人工智能和机器学习的开源软件平台])等标准的东西,并在机器层面上进行转换,oneAPI提供了一种有效的方法来实现这一目标。用户可以在AI框架级别使用通用API,我们有一个API(oneAPI)来解决不同的硬件口味。”因此,一个通用的API意味着用户可以创建开放的软件,这些软件可以在开放的软件堆栈上得到支持。 GPU级的性能在CPU级的价格点 IT的进步很大程度上是由对持续的技术进步的期望驱动的,这种技术进步与部署策略中的洞察力驱动的改进相结合。这是一个基于在预算支出和业务投资回报率之间找到最佳可实现平衡的模型,并且期望总是有进一步的创新需要努力。人工智能代表了这种理想的巅峰——它足够聪明,可以通过不断的自我完善来重塑自己的价值主张。 通过将AMX加速器构建到第四代英特尔至强CPU中,英特尔展示了如何在CPU级别的价格点上实现GPU级别的性能。这使得数据中心可以扩展,同时最大限度地提高现有英特尔至强处理器的回报价值,但也提供了一种定价模式,为拥有人工智能工作负载但预算有限的客户降低了入门成本。 CPU较低的功耗意味着能源效率可以在数据中心设施的整个运行过程中全面实现,比如冷却和通风,这是可持续性的另一个成功因素——负责任的软件架构师和人工智能解决方案的开发人员。 原文《The role of the CPU in sustainable AI/ML》 |

原创栏目

企业视频

IT百科

网友评论

聚超值•精选

-

- ikbc机械键盘无线办公键盘cherry樱桃轴有线键盘笔记本电脑外接键盘电竞游戏键盘 W200黑色无线2.4G87键 红轴

- 券后省40

-

¥209.0

¥249.0

- 小米(MI)Redmi Buds 5 Pro 真无线降噪耳机 入耳式舒适佩戴 小米华为苹果手机通用 Redmi Buds 5 Pro 冰瓷蓝

- 券后省10

-

¥389.0

¥399.0

- 声阔(SoundCore)Life Q20i头戴式蓝牙耳机主动降噪重低音无线耳麦金标认证高音质适用苹果/华为手机电脑笔记本

- 券后省10

-

¥248.0

¥258.0

- 西部数据(WD) 2TB 移动硬盘 USB3.0 My Passport随行版2.5英寸白 机械硬盘手机笔记本外置外接存储兼容Mac

- 券后省10

-

¥559.0

¥569.0

- Apple/苹果2020款MacBookAir13.3英寸M1(8+7核) 16G 512G深空灰轻薄笔记本电脑 Z124000CG【定制】

- 满3000减400

-

¥10199.0

¥10999.0

-

- 联想笔记本电脑小新Pro14轻薄本 英特尔Evo 14英寸超能本(14核标压i9 16G 512G 2.8K高刷屏)银 商务办公学生

- 券后省10

-

¥6489.0

¥6499.0

- ulanzi优篮子 VL49 RGB磁吸全彩补光灯便携LED口袋双色温摄影灯微单相机手机室内人像特效

- 券后省5

-

¥94.0

¥99.0

- 步步高家教机S6 8+256G 12.7英寸 英语学习机 护眼平板电脑 学习机 学生平板 点读机 早教机

- 券后省500

-

¥4398.0

¥4898.0

- 萤石家用无线摄像头室内高清监控摄像机 360度云台旋转C6C CP1监控器 【1080P性价比】CP1青春版 标配(享32G内存卡)

- 券后省10

-

¥159.0

¥169.0

- 西部数据(WD)加密移动硬盘固态 My Passport随行版SSD 防摔防震 安全 高速1050MB/s 兼容MAC 笔记本电脑外接 4TB(WDBAGF0040BGY)深空灰 官方标配

- 送赠品

-

¥2079.0

¥2129.0

-

- ThinkPad T14s 联想14英寸高性能轻薄笔记本电脑(酷睿i5-1240P 16G 512G 高色域)4G版 商务办公

- 券后省10

-

¥7989.0

¥7999.0

- OPPO K11x 1亿超清影像 超大内存 67W闪充 长续航 120Hz 12GB+256GB 珠光 智能 拍照 防水 5G 学生手机

- 券后省200

-

¥1399.0

¥1599.0

- JBL GO4 音乐金砖四代 蓝牙音箱 户外便携音箱 电脑音响 低音炮 jbl go4 音响 礼物小音箱 月光白

-

¥399.0

¥429.0

- AOC Q2790PQ 27英寸显示器 2K高清 IPS广视角 广色域 节能低蓝光 75HZ 可升降旋转液晶电脑显示屏

- 券后省10

-

¥1139.0

¥1149.0

- 小米(MI)Redmi Buds 5 Pro 真无线降噪耳机 入耳式舒适佩戴 小米华为苹果手机通用(曜石黑)

- 券后省10

-

¥379.0

¥389.0

-

- 小霸王M9pro游戏机连接电视PSP双人无线手柄摇杆家用街机家庭主机怀旧红白机 【高配版】128G+双无线手柄+预装19000款游

- 券后省20

-

¥258.0

¥278.0

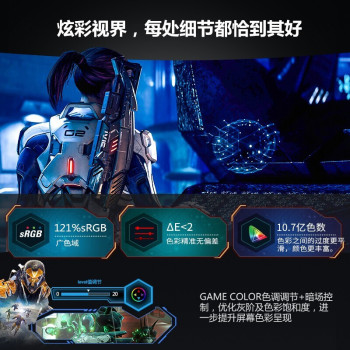

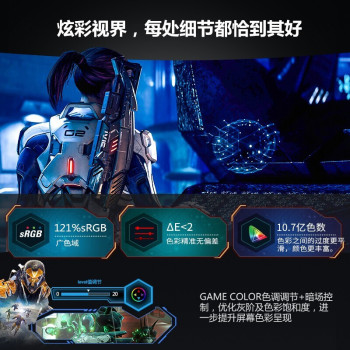

- AOC AG322QX 31.5英寸 2K显示器165Hz 1ms HDR 10.7亿色 IPS 电竞显示屏

- 券后省10

-

¥2289.0

¥2299.0

- AMD 锐龙 CPU 台式机处理器 R7 5700X3D 散片CPU

- 券后省30

-

¥1479.0

¥1509.0

- 天猫精灵 智能音箱蓝牙音响 智能小闹钟时钟家用早教机 语音声控智能AI音箱 情人节生日礼物 微信收款 【标准版】方糖3 白色

- 每满109减10

-

¥99.0

¥109.0

- 魅族(MEIZU)20 Classic 骁龙8Gen2 Flyme系统 144Hz电竞直屏 5G游戏学生拍照 魅族20C 悠扬乌铁 16+512GB

- 券后省50

-

¥2649.0

¥2699.0

佚名

佚名

硬件编年史

硬件编年史